书名:海洋水下成像与压缩传输

ISBN:978-7-115-62928-9

本书由人民邮电出版社发行数字版。版权所有,侵权必究。

您购买的人民邮电出版社电子书仅供您个人使用,未经授权,不得以任何方式复制和传播本书内容。

我们愿意相信读者具有这样的良知和觉悟,与我们共同保护知识产权。

如果购买者有侵权行为,我们可能对该用户实施包括但不限于关闭该帐号等维权措施,并可能追究法律责任。

著 沈礼权 张 曦 等

责任编辑 贺瑞君

人民邮电出版社出版发行 北京市丰台区成寿寺路11号

邮编 100164 电子邮件 315@ptpress.com.cn

网址 http://www.ptpress.com.cn

读者服务热线:(010)81055410

反盗版热线:(010)81055315

本书介绍以海洋水下光学和声学成像为主的图像处理技术,主要阐述海洋水下成像方法和压缩传输的关键技术,内容包括海洋水下成像与压缩传输概述、基于光学/声学的海洋水下成像、海洋水下图像质量评价、海洋水下图像质量增强、海洋水下图像压缩、海洋水下目标检测与跟踪,以及海洋水下成像系统。

本书既可作为海洋船舶、电子信息、计算机、光电子、通信等领域研究机构和企业的科研人员、设计人员进行相关研究和新技术开发时的参考书,也可作为上述领域相关专业的本科生、硕士研究生、博士研究生的学习用书,或高校中相关专业教师的教学、科研参考书。

党的十九大报告提出“坚持陆海统筹,加快建设海洋强国”。近年来,我国海洋经济保持总体平稳的发展势头,是拉动国民经济发展的重要引擎。《国家“十二五”海洋科学和技术发展规划纲要》将海洋海量数据快速传输和海洋场景及海洋现象的真实显示与动态仿真等列入海洋科技发展的重要任务。中华人民共和国国家自然科学基金委员会(简称国家自然科学基金委)将“海洋信息获取和传输”列入重点支持领域。海洋信息获取与传输在海洋探测、观测等方面起着重要的作用。海洋水下成像作为海洋信息获取直接而有效的手段,具有扰动小、观测面积大等优点,其发展备受关注。

海洋水下成像的数据量巨大。水声传输存在带宽窄(20~100kbit/s)、波动大且误码率高等问题,其数据无法无线实时传回,必须通过取回设备或有线方式才能获得。这使深海探测非常烦琐,甚至难以实现。现有水下无线传输无法实现高速率数据传输,这是目前亟待解决的核心问题。同时,海洋水下成像数据往往面向机器测量应用,其处理的本质不仅在于面向显示的感知计算,还在于面向测量的感知计算。针对上述核心难题,美国、欧洲各国、日本、韩国和我国的高校、研究所、相关企业逐步掀起了海洋水下成像与压缩传输的研究热潮,并开始将其应用于各个领域。

本书是在国家自然科学基金重点项目“深海水下成像与压缩传输”(61931022)、国家重点研发计划深海重点专项项目“深海生物数字化原位观测记录系统”(2016YFC0302402)、上海市科学技术委员会人工智能专项“自适应深度学习算法及面向海洋开放场景的应用”(22511105200),以及上海市优秀学术带头人项目“面向海洋水下场景的动态点云编码与3D对象重建”(23XD1401400)资助下所取得的研究成果的基础上完成的,并参考和融入了国内外现有的基本理论和研究成果。

海洋水下成像的种类甚多,常随应用场景的不同而异。本书重点介绍光学成像、声学成像和相关压缩传输的关键技术。本书共分7章。第1章首先阐述海洋水下成像与压缩传输的研究背景与意义,同时简要介绍海洋水下成像与压缩传输系统,随后分析国内外研究动态与现状。第2章首先阐述海洋水下光学成像,包括水下物理成像模型、人工光源辅助的海洋水下光学成像,以及深海浮游生物自发光成像;随后介绍海洋水下声学成像,包括水下声呐成像原理与常用成像声呐。第3章~第6章是本书的重点:第3章首先概述海洋水下图像质量评价的基础理论与相关算法,随后分别介绍一个大型海洋水下图像质量评价数据集和两种不同的水下增强图像质量评价算法;第4章首先概述海洋水下图像质量增强的基础理论与相关算法,随后分别具体介绍5种不同的水下图像增强算法;第5章首先概述海洋水下图像压缩的基础理论与相关算法,随后分别介绍先验引导的自适应水下图像压缩感知算法、基于水下物理先验的极低码率压缩网络、物理先验引导的水下图像分级压缩算法、面向机器视觉的先验引导水下图像压缩算法,以及面向多类机器视觉任务的特征分级压缩算法;第 6章首先概述海洋水下目标检测与跟踪的基础理论与相关算法,随后分别介绍海洋水下光学目标检测、基于散斑抑制和场景先验的水下前视声呐图像目标检测网络,以及基于位置引导图的水下声呐图像目标检测算法。第7章则先后介绍基于ROV 的海洋水下成像与压缩传输系统、发光浮游生物检测分析仪,以及该分析仪的海上试验。

本书由沈礼权拟定全书的大纲,撰写第1章、第2章,并对全书进行统稿、修改和定稿;由汪正勇、王哲寅等撰写第3章;由汪正勇、余檬、林宇飞、王堃等撰写第4章;由李梦瑶、张羽、方正凯、庄立昊等撰写第5章;由沈程、曹磊、龙辉等撰写第6章;由张曦、赵其杰、曹磊等撰写第7章。本书为上海高水平地方高校建设计划 2023 年度上海大学一流研究生教育培养质量提升项目成果。此外,在编著本书的过程中,作者得到了国家自然科学基金委、上海市科学技术委员会、上海大学通信与信息工程学院的大力支持,在此表示衷心感谢。

本书聚焦前沿交叉领域,由于作者水平有限,书中难免存在不足之处,谨请读者指正。

作者

2025年6月24日

21世纪是“海洋世纪”,海洋逐渐成为国际政治、经济、军事、科技等领域合作与竞争的重要舞台。党的十八大首次把“建设海洋强国”写进大会报告,党的十九大报告再次提出“坚持陆海统筹,加快建设海洋强国”。近年来,我国海洋经济保持总体平稳的发展势头,是拉动国民经济发展的重要引擎。海洋生产总值占国内生产总值的比例逐年增长。海洋科技创新是海洋各领域发展的重要保障。

《国家“十二五”海洋科学和技术发展规划纲要》将开发多源多尺度时空海洋数据同化、融合、处理、集成应用和挖掘技术,海量数据快速传输、管理和安全保障技术,海洋场景及海洋现象的真实显示与动态仿真技术等列入海洋科技发展的重要任务。国家自然科学基金委员会将“海洋信息获取和传输”列入重点支持领域。海洋信息获取与传输对国计民生至关重要,在海洋探测与环境监测、海洋维权、海洋资源开发、海洋灾害预警、国防建设等方面起着非常重要的作用。海洋水下成像作为海洋信息获取的直接且有效的手段,与其他探索技术相比,具有对水下环境扰动小、探测覆盖面积大等优点,其发展备受关注。海洋水下成像与压缩传输等核心技术在未来海洋战略中扮演着日益重要的角色。

海洋水下成像按成像方式可分为海洋水下光学成像和海洋水下声学成像。海洋水下光学成像一般用于对海洋目标进行人眼观察或视觉识别,其分辨率往往高于海洋水下声学成像,但必须在有光源且清澈的水中才能工作。根据光源的不同,海洋水下光学成像可以分为可见光成像和深海浮游生物自发光成像。海洋水下声学成像往往用于水下测量和水下目标探测,对工作环境的要求远低于海洋水下光学成像。它无须使用照明设备,且在低能见度条件下表现出较好的性能,但存在区域数据缺失和目标细节较差的缺点。

海洋水下成像按传感器数量可分为单传感器和多传感器两种方式。与单传感器方式相比,多传感器(如光学传感器+声学传感器)方式有众多优点,包括:①声学传感数据应用于机器测量和识别,可满足高效测量的要求;②多目光学传感数据可灵活生成水下三维场景,便于显示终端实现立体化成像,让用户从不同角度观测水下场景,实现高效的水下场景重建与显示。

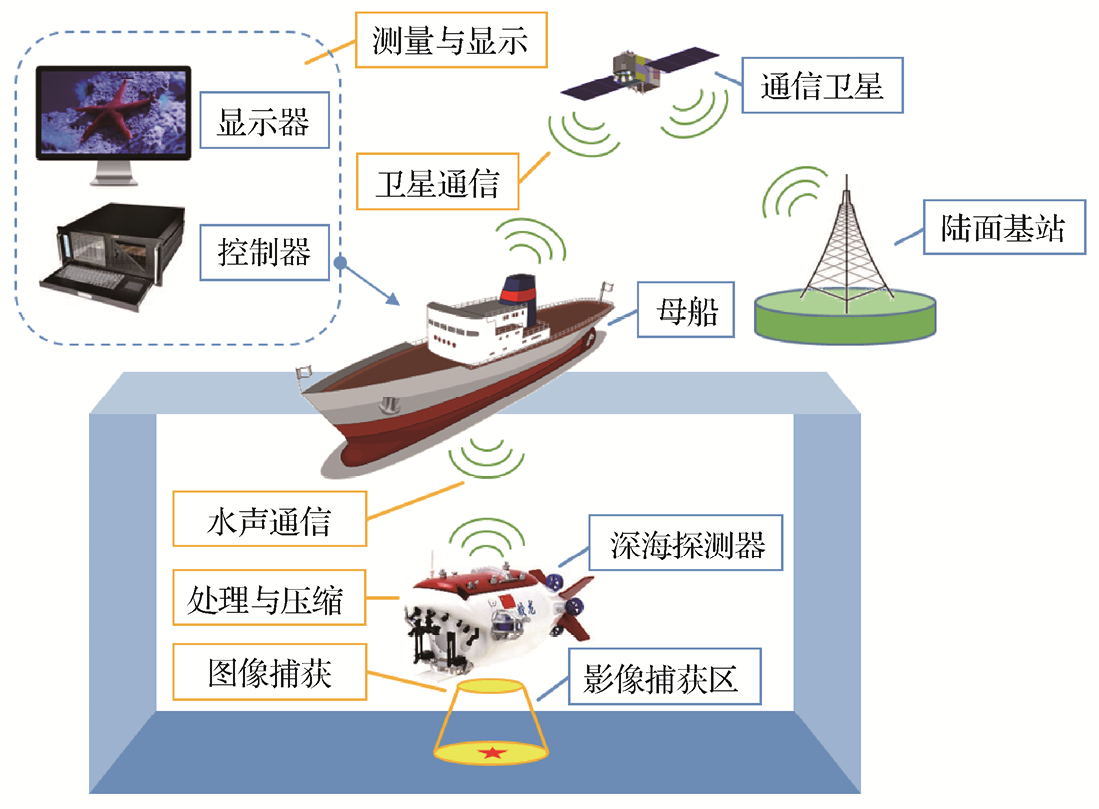

海洋水下信息传输方式有本位存储(通过取回存储设备实现数据传输)、有线传输和无线传输3种。本位存储可保存的数据有限,使用周期短。有线传输使用极其不便,不适合长距离传输和动态观测。无线传输包括可见光通信、电磁波通信和水声通信(指水下声学传输):可见光通信仅能在非常清澈的水域中工作;电磁波通信在甚低频波段仅能穿透深度为30m的海水;水声通信则是目前远距离海洋数据无线传输比较可靠的方式。图1.1所示为海洋水下通信系统,包括水声通信、卫星通信等。

图1.1 海洋水下通信系统

海洋水下成像系统的传输性能在很大程度上取决于水下场景特征和信道类型,受多径干扰的影响,其传输带宽通常小于 100bit/s,难以用现有理论方法直接实现高速率的视频数据传输。因此,需对海洋水下图像(本书简称水下图像)数据进行甚低码率压缩、高鲁棒性传输,在传输之前先进行预处理或图像质量增强,在传输后再进行面向显示或机器测量的压缩重构。这些烦琐的处理成为水下无线视频通信系统发展的瓶颈。

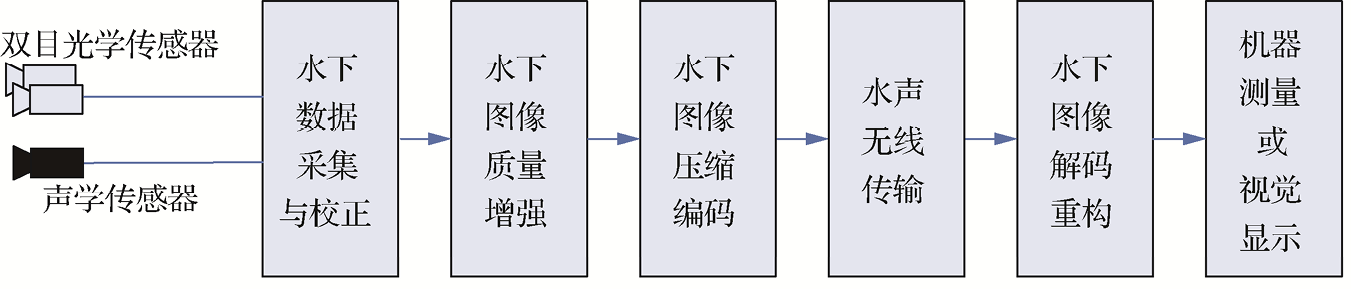

就现有海洋水下成像与压缩传输系统而言,基于多传感器的方式能够获取更加精确的场景信息。图1.2所示为海洋水下成像与压缩传输系统的基本框架,它由水下数据采集与校正、水下图像质量增强、水下图像压缩编码、水声无线传输、水下图像解码重构、机器测量或视觉显示等环节组成。与空气媒介中的无线视频传输与处理系统相比,海洋水下成像与压缩传输系统具有以下主要特点:①水声信道传输速率低、波动大,且传输误码率高;②水下视频不仅服务于人眼视觉,还会面向机器测量和识别;③水下成像条件恶劣,造成水下图像/视频质量、目标细节较差;④多数情况下,水下场景相对稳定、变化小,探测对象的形状可计算。

图1.2 海洋水下成像与压缩传输系统的基本框架

随着人类对海洋环境资源和自然资源的日益重视,认识海洋、发展海洋、控制海洋成为各国高新技术发展的重要目标。海洋强国(如美国、欧盟各国、日本、俄罗斯、加拿大、韩国、新加坡等)都十分重视海洋探测研究。例如,美国在2022年发布了《2030年海洋研究与社会需求的关键基础设施》,英国在2010年发布了《英国海洋科学战略2010—2025》,日本在2023年发布了新版《海洋基本计划》,等等。海洋信息获取和处理等高新科学技术成为各国的重要研究课题,也是各国开展海洋高端装备研发的基石。我国在海洋领域的研究虽然起步稍晚,但深受国家重视,近年来已在无人艇、无人潜水器、载人潜水器、深海滑翔机等多项关键技术上获得了突破性进展,并已在南海与东海部署了海底观测网。

在海洋水下探测领域,图像作为最重要的信息载体,其生成与压缩传输成为目前海底探测的瓶颈。现有海洋水下探测在无缆方式下仅能回传非常少量的数据,而当探测器需要捕获图像视频信息时,由于水声信道传输速率很低且存在波动大、误码率高等问题,水下场景数据无法实时传回,需要通过取回设备或有缆连接的方式才能获得数据,这使探测任务变得非常烦琐,甚至难以实现。海洋水下成像与压缩传输是一种以获取水下图像信息为目的的光、声、机、电、算相结合的技术,它涉及水下成像、图像处理和信号传输系统等多方面理论与方法。针对水下图像传输,国外有一些学者曾提出应用现有或改进型技术,如MPEG-4、JPEG 2000、基于调色板压缩算法等对图像进行编码,但编码效率远远不足以进行实时图像捕获与传输。水下图像数据存在新的空时分布,冗余存在新规律,即使直接采用最新视频压缩标准(VVC/H.266标准)进行压缩也难以满足水声信道传输甚低码率的要求。因此,研究针对水下图像特点进行图像质量增强、甚低码率编码、高效传输以及高质量重建的海洋水下成像与压缩传输系统是非常紧迫的任务。就海洋水下成像与压缩传输的重要问题,本节从海洋水下成像、海洋水下光学图像质量增强、海洋水下图像压缩、海洋水下图像质量评价、海洋水下多类机器视觉任务等方面分别进行介绍。

海洋水下成像包括光学成像和声学成像两种方式。光学成像具有探测目标直观、成像分辨率高、信息含量高、图像质量好、图像帧率高等优点,但必须在有光源且清澈的水中才能工作。光作为电磁波的一种形式,其能量在水中的传播是按指数级衰减的。一般情况下,水下200m以下的可见光照度不足水面照度的 0.01%,而在 1000m 以下的深海中,周围环境更是一片漆黑。因此,深海光学成像系统主要采用主动式成像方式,即配备深海照明。国际上,美国的伍兹霍尔海洋研究所、Deepsea Power&Light公司,挪威的Kongsberg公司等都具备深海照明灯的研制能力。我国的深海照明系统研发虽然起步较晚,但已取得了进步。海洋光学相机系统按其技术特点,可分为水下普通相机、激光成像相机、偏振成像相机、立体成像/全景成像相机、显微成像相机及光谱成像相机等。

基于浮游生物自发光的弱光成像是深海探测的重要方式。有研究认为,超过75%的海洋生物是能够发光的,它们具有自发光或受激发光的特性。特别是在水深超过1000m的深海水层中,90%的生物都能够发光。基于深海中发光生物的庞大比例和它们的发光特性,研究人员发展出多种基于生物自发光的海洋浮游生物光学成像系统。这些系统的检测原理是先通过一定的手段刺激目标生物发光,为图像采集提供照度;然后利用高灵敏、低噪声的微光相机在黑暗的深海环境中实现对目标生物图像的采集。

声呐成像作为海洋探测的重要技术手段,在水下目标跟踪、海床建模、水雷探测、打捞救助、鱼群定位等方面得到应用。水下声呐成像往往用于水下测量和目标探测,在低能见度和浑浊的水下环境表现出较好的性能。水下声呐图像与光学图像的不同之处在于,声呐图像不包括颜色信息,图像分辨率较低、目标细节较差。

水下光学成像时,光会受到水体的吸收和后向散射,造成水下图像质量较低、图像对比度低、图像纹理模糊等诸多问题。具体表现为:一方面,红光在水中衰减最大,蓝绿光衰减最小,这会影响水下光学成像色彩的真实性;另一方面,水体的前向散射和后向散射会导致水下光学成像质量显著降低。前向散射会使光线受到水介质的作用以小角度偏离原来的传输方向,使光线的一个点扩散为弥散斑,导致图像模糊;后向散射会使光线因穿过水体时被散射而使反向部分被传感器捕获,形成雾化效果,导致图像对比度降低。水下图像的噪声所引起的图像模糊、对比度低等问题,特别是回波信号干扰和前向散射所引起的“雾化”,会导致水下图像在时域上不连续和时域预测不准确,进而大幅降低水下图像的处理效率。因此,水下光学图像的质量增强是非常必要的。

随着海洋成为世界各国探索和研究的重要对象,海洋水下图像增强领域也成为学术界的热点话题。国内外的学者提出了大量水下图像增强算法,主要可以分为三大类:基于像素点的水下图像增强、基于水下物理成像模型的水下图像增强以及基于深度学习的水下图像增强。基于像素点的水下图像增强算法主要使用对比度拉伸、白平衡、直方图均衡等方法对水下图像进行增强。基于水下物理成像模型的水下图像增强算法主要使用颜色、暗通道等先验知识,估计水下物理成像模型中的参数,进而对水下物理成像模型进行反向推导并代入参数,获得增强后的水下图像。随着计算机科技的迅速发展,深度学习被广泛应用于图像增强、图像分类、图像识别等领域。由于深度学习强大的学习能力,其在水下图像增强领域的应用越来越广泛。基于深度学习的水下图像增强算法主要使用卷积神经网络(Convolutional Neural Network,CNN)学习水下图像到清晰无失真图像的非线性映射关系。

由于光在水中传输时具有散射和吸收特性,水下图像往往具有对比度低、清晰度低、颜色失真等像素级问题。基于像素点的水下图像增强算法从像素级的角度考虑,使用对比度拉伸、白平衡、直方图均衡、Retinex(一种基于颜色恒常性理论的方法)、伽马矫正、锐化等方法提高水下图像的清晰度,并恢复水下图像的色彩。

(1)对比度拉伸

Iqbal等人提出了基于滑动拉伸的增强算法,可用于解决水下图像的颜色失真问题。该算法在RGB颜色空间对水下图像进行对比度拉伸,从而对图像的颜色进行均衡化。对比度拉伸算法在色调-色饱和度-亮度颜色空间对图像的饱和度和亮度进行拉伸,以解决图像色偏和低亮度问题[1]。Fu等人提出了一种两阶段的水下图像增强算法,将水下图像增强任务分为了两个子任务,提出基于分段线性变换的色彩校正策略来解决水下图像色彩失真问题。他们设计的最佳对比度改进算法可以有效减少伪影,从而解决水下图像对比度低的问题[2]。由于该算法的大多数操作是基于像素点计算的,因此容易实现且适合实时应用。

(2)白平衡

Ancuti等人提出了基于图像融合的增强算法。该算法首先对水下图像分别进行白平衡颜色校正和对比度增强以得到两个融合分量,然后为每个融合分量计算4个融合权重,最后对两个融合分量使用融合权重加权后进行图像融合,得到最终的增强结果[3]。Ancuti等人进一步提出了基于颜色平衡与图像融合的水下图像增强算法。首先,该算法基于红色通道补偿的白平衡算法对水下图像进行颜色矫正,解决了现有的白平衡算法应用在水下图像上导致的红色伪影问题;使用伽马矫正调整图像的全局对比度,增加了图像较暗区域和较亮区域之间的差异[4]。其次,该算法为了弥补伽马矫正导致的过曝光区域的细节损失,还对白平衡处理后的图像进行了锐化,加强了图像的纹理和细节。最后,该算法使用高斯金字塔及拉普拉斯金字塔对伽马校正后的图像和锐化后的图像进行多尺度融合,得到最终的增强结果。

(3)直方图均衡

Hitam等人提出了面向水下图像增强的混合对比度自适应直方图均衡算法。该算法分别在RGB颜色空间和HSV颜色空间进行混合对比度自适应直方图均衡,并使用欧几里得归一化将其融合,得到最终的增强结果[5]。

(4)Retinex

Fu等人提出了基于Retinex的水下图像增强算法,将水下图像增强分为3个步骤。首先,使用高效的颜色校正算法来解决水下图像的颜色失真问题。其次,基于 Retinex 将水下图像分解为反射层和照度层,并分别对反射层和照度层进行自适应增强,解决水下图像欠曝光和模糊的问题。最后,将处理后的反射层和照度层融合,得到最终增强的水下图像[6]。

基于像素点的水下图像增强算法从像素级的角度直接调整图像的像素值,并没有考虑水下物理成像模型。因此,此类算法往往忽略了水下环境中复杂的光散射和吸收现象,无法有效地处理水下图像的模糊和颜色偏差问题,进而导致增强结果欠佳。

1990年,Jaffe对光在水中传输的退化过程进行建模,提出了水下物理成像模型[7]。随后,研究人员将水下物理成像模型应用到水下图像增强领域。此类算法首先将水下物理成像模型看作一个可逆问题,使用暗通道先验、颜色先验、直方图分布先验等先验知识,估计水下物理成像模型中的参数,包括传输图、背景光、衰减系数等;随后,反向推导出水下物理成像模型并代入参数,对水下图像进行增强和复原。

(1)暗通道先验算法

Drews等人通过观察水下图像中红通道的光吸收率相关性,将去雾领域的暗通道先验算法改进为面向水下图像的暗通道先验算法,并使用大量水下图像验证了该先验算法的有效性。随后,Drews等人使用该先验算法估计水下物理成像模型中的深度图参数,反向推导出水下物理成像模型并代入参数,对水下图像进行增强[8]。Chiang 等人提出了基于波长补偿和去雾的水下图像增强算法[9]。首先,该算法考虑了可能存在的人工光源的影响,使用暗通道先验算法估计出水下图像的深度图信息后,通过深度图区分水下图像的前景和背景区域。其次,该算法根据前景和背景的光强度差异确定水下图像中是否有人工光源的影响,并对人工光源进行处理和补偿。接着,该算法基于水下物理成像模型修正水下图像的雾现象,并补偿不同波长的光在水中传播的衰减差异。最后,该算法根据背景光中不同颜色通道的剩余能量比来估计水下图像场景的水深,并根据不同光波长对应的衰减量,进行颜色变化补偿,以恢复颜色平衡。Galdran等人将水下图像的红色通道具有高衰减的特性与暗通道先验算法结合,提出了基于红色通道先验的水下图像增强算法[10]。

(2)其他先验算法

Li 等人提出了基于最小信息损失和直方图分布先验的水下图像增强算法。该算法提出了基于水下物理成像模型和最小信息损失原则的水下图像去雾模块,以恢复水下图像的灰度和颜色信息。同时,该算法还提出了基于直方图分布先验的对比度增强模块,可增加水下图像的对比度和亮度[11]。Peng等人提出了基于雾现象与光吸收现象的水下图像增强算法,他们认为基于暗通道先验和最大强度先验算法估计深度图的方式经常因为水下图像中的光照条件而失效,导致参数估计不准确以及增强效果不佳。因此,该算法提出了基于水下图像雾现象和光吸收现象的深度图估计模块,可以更准确地估计水下图像的深度图信息,并将该深度图信息引入水下物理成像模型,用于增强水下图像[12]。Akkaynak等人通过海洋实地勘探,对水下物理成像模型进行了修正。随后,他们通过测量水下场景的水平深度、估计衰减系数,并基于修正的水下物理成像模型对水下图像进行增强[13]。Berman 等人提出了基于模糊线的水下图像增强算法。该算法研究了不同水质类型的光谱特性,仅通过估计水下图像的蓝色通道和绿色通道的衰减率,就可将水下图像增强简化为图像去雾问题[14]。

基于水下物理成像模型的水下图像增强算法引入了水下物理成像模型,因此可以将水下的光散射和吸收问题考虑在内。然而,此类算法所使用的先验算法在面临复杂多变的水下场景时会失效,导致无法准确地估计水下物理成像模型中的参数,这严重地降低了此类算法的性能表现。

深度学习需要依赖数据集训练神经网络模型,但是水下图像增强无法在拍摄水下图像的同时获取对应的清晰且无失真的图像作为参考图像。如何构建有效的水下图像增强数据集成为基于深度学习的水下图像增强算法面临的首要问题。截至本书成稿之日,现有的水下图像增强数据集可以分为两类:合成水下数据集和真实水下数据集。研究人员提出了对应的算法来解决这两类数据集各自存在的问题。因此,基于深度学习的水下图像增强算法可以分为基于合成水下数据集的增强算法和基于真实水下数据集的增强算法。

(1)基于合成水下数据集的增强算法

为了构建有效的水下图像增强数据集,研究人员使用陆地拍摄的图像及其对应的深度图信息,根据水下物理成像模型合成带有水下失真的图像,并通过调节水下物理成像模型中的衰减系数,改变合成图像的失真程度。基于合成水下数据集的增强算法可分为两类:基于端到端网络的深度学习算法和基于物理模型的深度学习算法。

Wang等人首先基于水下物理成像模型合成了一个包含200 000张图像的合成水下数据集,并基于该数据集提出了面向水下图像增强的端到端CNN模型,并将其命名为UIE-Net[15]。该网络包含两个子模块:颜色校正模块和去雾模块。其中,颜色校正模块用于估计水下图像RGB三通道的衰减系数;去雾模块用于估计传输图。该网络通过对水下物理成像模型进行反向推导并带入估计的参数,得到最终的增强结果。Li等人提出了面向水下图像颜色矫正的无监督生成对抗网络(Generative Adversarial Network,GAN),并将其命名为WaterGAN。该网络首先利用GAN模拟水下物理成像模型,并利用大气自然图像与其对应的深度图合成水下数据集。随后,基于该合成数据集构建了端到端的颜色校正网络,对水下图像进行颜色校正。Li 等人基于水下物理成像模型构建了一个包含 10类不同水质的合成水下数据集,并针对每一类水质训练了对应的端到端CNN模型[16]。Dudhane等人构建了一个全新的合成水下数据集,并提出了面向水下图像增强的端到端CNN。该CNN包含两个模块:RGB通道颜色特征提取模块和密集残差特征提取模块[17]。

Wang等人提出了基于平行CNN的水下图像增强算法。该算法包含两个平行分支:传输图估计网络和背景光估计网络。其中,传输图估计网络中引入了多尺度融合和卷积层连接,解决了传输图的伪影问题。该算法将传输图和背景光参数输入水下物理成像模型并反向推导,得到了最终的增强结果[18]。Zhou等人为了解决用合成水下数据集训练的网络模型对水下真实图像泛化性差的问题,将域自适应损失函数引入GAN,使网络模型学习合成图像与水下真实图像特征分布的差异,从而使用合成水下数据集训练的网络模型有效地增强了水下真实图像[19]。Wang等人提出了基于联合迭代的端到端图像增强网络。该网络包含两个模块:基于孪生网络的颜色校正模块和循环去雾模块。此外,该算法引入了循环迭代更新机制,用于联合优化颜色校正模块和去雾模块[20]。

虽然上述基于合成水下数据集的增强算法的性能与传统算法相比有着较大的进步,但是其中基于端到端CNN的算法,没有将水下物理成像模型的失真过程考虑在内,导致此类算法无法真正有效地解决雾现象和颜色失真问题。此外,基于水下物理成像模型的深度学习算法在估计水下物理成像模型中的参数时没有使用任何先验信息,导致参数估计不准确。这些算法还将水下图像增强看作单阶段的过程,直接将估计的参数代入水下物理成像模型以得到增强结果,忽略了水下失真过程的渐进性。上述两个问题导致了基于水下物理成像模型的深度学习算法的效果不佳。基于上述问题,上海大学研究团队对基于合成水下数据集的增强算法展开了研究,并提出衰减系数引导的两阶段海洋水下图像增强算法。该算法可以准确地估计水下物理成像模型中的参数,并有效地解决了海洋水下图像的散射和颜色偏差问题。

(2)基于真实水下数据集的增强算法

基于合成水下数据集训练的 CNN 往往对水下真实图像的泛化性较差,导致增强结果的视觉感知质量较差,因此研究人员开始使用真实水下数据集训练CNN,从而提升对水下真实图像的泛化性。

Li等人提出了水下图像增强基准(Underwater Image Enhancement Benchmark,UIEB)数据集,该数据集完全基于水下真实图像构建。Li等人首先收集了890张水下真实图像,并挑选了12种水下图像增强算法分别对每张水下图像进行增强。其次,他们邀请了20位志愿者对每张增强的水下图像进行主观质量打分,并选取主观质量分数最高的增强图像作为水下图像对应的参考图像。最后,Li等人使用 UIEB 数据集训练了一个面向水下图像增强的 CNN,并将其命名为Water-Net。该算法先对水下图像分别使用白平衡算法、直方图均衡算法、伽马矫正算法进行预处理,再使用 CNN 估计融合权重,并进行多图像融合,从而得到最终的增强图像[21]。

Fabbri 等人将 GAN 引入水下图像增强领域[22]。他们首先使用不成对的清晰水下图像和质量较差的水下图像训练CycleGAN网络,使该网络可以基于清晰水下图像生成与其对应的退化失真图像。然后,他们将该成对的数据集用于增强网络的训练。Islam等人于2020年构建了一个包含成对图像集的真实水下数据集,并将其命名为EUVP[23]。他们首先收集了清晰的水下原始图像与模糊的水下原始图像,并基于这些图像训练了基于 CycleGAN 的深度模型,来学习清晰水下图像到模糊水下图像的映射。然后,他们将清晰水下图像输入该深度模型以生成模糊的水下图像,从而构建了一个成对的数据集。基于EUVP数据集,Islam等人提出了基于条件的GAN(condition GAN,cGAN)的深度模型FUnIE-GAN,用于水下图像增强。FUnIE-GAN使用生成对抗损失函数学习清晰水下图像与模糊水下图像之间的特征分布。该损失函数可以使FUnIE-GAN调整输入的模糊水下图像的特征分布,使其逼近清晰水下图像。此外,该模型可通过提取全局特征信息、颜色信息、局部纹理信息和图像风格信息对水下图像进行增强。

Li等人提出了基于弱监督的颜色迁移算法对水下图像进行颜色矫正。该算法基于CycleGAN的思想,不再使用成对的数据集训练网络模型,并引入了生成对抗损失函数、循环一致性损失函数、结构相似性损失函数监督网络模型学习水下图像与大气自然图像的分布差异。该算法在保证增强结果的内容结构与输入水下图像一致的前提下,使颜色分布与大气自然图像相似[24]。Hu 等人提出了面向水下图像增强的双分支CNN。该网络使用HSV颜色空间的信息对水下图像的色度信息与亮度信息进行分解,并将H通道和S通道输入基于GAN的颜色矫正分支,将V通道输入对比度增强分支。最终,该网络将处理后的H通道、S通道、V通道重新融合,得到增强结果[25]。Li等人提出了基于传输图引导和多颜色空间嵌入的水下图像增强网络。该网络首先从RGB颜色空间、HSV颜色空间、CIELab颜色空间(简称Lab颜色空间)提取水下图像的多种特征表达,并引入注意力机制对特征表达进行加权融合。随后,该网络通过将水下图像的传输图引入网络模型中,使网络对图像中衰减严重的区域进行着重增强[26]。

虽然基于真实水下数据集的增强算法对水下图像有较好的泛化性,但是此类算法既没有将视觉感知质量直接考虑在内,也没有约束 CNN 从视觉感知质量的角度优化参数,导致其增强结果的客观质量评价指标较高,视觉感知质量却不佳。

现有的水下图像/视频预处理方法能够完成某一特定场景的噪声去除,但缺乏针对光学图像和声学图像的不同增强思路。例如,对于面向显示的光学图像,应保留其显示感知特征;而对于面向测量的图像,应保留其测量的特征区域,同时对图像进行自适应缩放,才能更有效地进行下一步压缩与传输。现有的水下图像/视频预处理方法未专门考虑“面向测量的场景信息获取、水下数据压缩和重建”,仅从“如何提高信噪比指标”出发来设计处理方法。

水下图像/视频传输可通过水下电磁波通信、水下光通信和水声通信等方式完成。其中,水声通信方式表现出较好的传输特性,被应用于长距离通信。在水声通信技术方面,国外起步较早:美国的伍兹霍尔海洋研究所、麻省理工学院、加利福尼亚大学等都较早地组建了有影响的水声通信团队,日本、葡萄牙等国的研究机构也深入开展了水声通信研究。我国近年来也在水声通信技术方面加大了研发力度,中国科学院声学研究所、哈尔滨工程大学、厦门大学、西北工业大学、浙江大学、东南大学、中国海洋大学、中国船舶重工集团公司第七一五研究所等高等院校及科研机构致力于水声通信技术的研究,在相干水声通信的研究领域取得了不俗的成果。我国自主研发的载人潜水器“蛟龙”号的水声通信机已实现了世界上首次7000m深度的潜水器与母船间的图像、语音、数据和文字的水声通信传输,但只能在一定时间内传输一张图像或一段视频,而无法对捕获到的图像/视频进行实时传输。

与空气媒介中的无线视频传输相比,受到水声信道传输速率的限制,水下图像码流的传输速率非常有限且波动大,易出现误码和丢包现象。因此,水下恶劣的环境不仅对水声通信的传输系统性能提出了较高的要求,还对传输图像的码率有严格的要求。国内外对水声图像传输的研究都是围绕着这两点来展开。图像压缩技术旨在通过减少图像本身像素数据的冗余(包括时间冗余、空间冗余、统计冗余、视觉冗余等)来对图像信息进行紧凑且保真的表达,以达到节省存储空间、提高传输效率的效果。本小节将现有的水下图像压缩算法分为两大类来进行介绍:一类为传统的图像压缩算法,另一类为基于深度学习的图像压缩算法。

在水下带宽有限的条件下,现有的水下图像压缩方案以传统编码方法为主,其中以小波变换(Wavelet Transform,WT)和主成分分析(Principal Component Analysis,PCA)这两类方法占主导。基于小波变换的水下图像压缩可较好地恢复图像低频纹理,基于PCA的水下图像压缩可利用图像间的共有特征来重建图像。此外,随着深度学习技术在计算机视觉领域的广泛应用,并依靠其在图像压缩方面体现出的巨大优势,基于CNN的水下图像压缩框架也被提出。虽然现有的基于深度学习的图像压缩算法仅是对神经网络的简单应用,但由于深度学习强大的拟合和表征能力,其与传统的图像压缩算法相比仍有较大优势。

小波变换是一种基于全局的变换,可实现对时间、空间频率的局部化分析,基于其正交性对信号进行多分辨率分解,反映信号本身存在的结构冗余。同时,由于小波分解在频率特性和方向特性方面与人眼视觉系统比较符合,因此小波变换在图像压缩领域的应用十分广泛。实际应用时,一般使用离散小波变换(Discrete Wavelet Transform,DWT)对数字图像进行压缩。

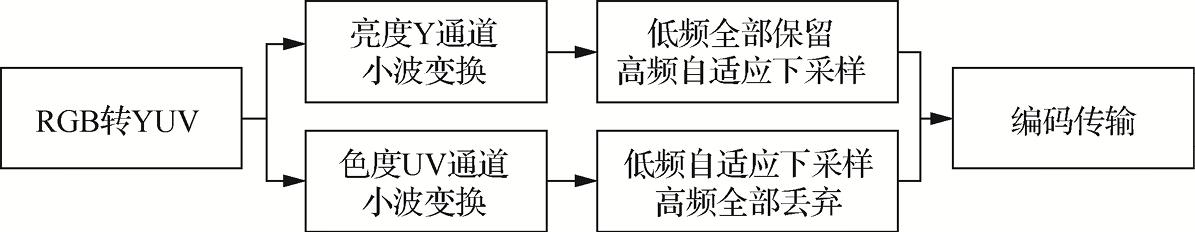

对于水下场景,水下图像具有成像过程对比度低、颜色不丰富、纹理细节少的特点,更有利于DWT在保证人眼感受的前提下实现较高的压缩率,因此大多数研究均采用DWT来实现水下图像的低码率压缩。基于DWT的水下图像压缩算法往往利用人眼视觉系统对高低频失真以及亮度、色度的敏感程度不同,对低频分量和亮度信息进行重点保留,对高频分量和色度信息进行不同程度的丢弃,实现数据的压缩,并保证重建图像的主观感受。此算法的大致流程如图1.3所示。由于YUV空间与人眼视觉系统更加符合,因此大多数算法首先将图像数据由RGB空间转换到YUV空间,然后对Y通道和UV通道分别进行不同的压缩处理。

图1.3 基于DWT的水下图像压缩算法的大致流程

He等人对亮度Y通道进行了四级小波分解,对色度UV通道进行了三级小波分解,其中每一级小波分解可得到4个分量(低频分量LL和高频分量LH、HL、HH),下一级分解则对低频分量LL再次分解,例如LL3代表第三级分解得到的低频分量,其数据量只有原始图像的1/64。由于人眼对色度较不敏感,色度UV通道经三级小波分解后只对低频分量LL3进行保留,高频分量全部被丢弃,其低频分量数据经4倍下采样后进行编码传输。而对于Y通道,其低频分量LL4数据被完全保留,每一级高频分量则根据其对重建图像峰值信噪比(Peak Signal-to-noise Ratio,PSNR)的贡献进行有选择的保留。其中,第一级高频分量由于数据量较大,且对PSNR影响不大,对其全部丢弃;第二、三、四级高频分量计算每一个分量被丢弃后最终重建图像PSNR的变化,作为该分量对PSNR的贡献。其中每一级贡献最大的一个分量被保留,另外两个分量被丢弃,保留分量的数据经两倍下采样后进行编码传输[27]。

与之相似,Zhang等人也利用小波变换在图像压缩上的优势,对水下图像进行了不同程度的分解。由于水下图像与普通大气自然图像相比颜色比较单一、视觉冗余较多,所以这类算法均在较高压缩率下实现了更高的重建PSNR[28,29]。然而,在低码率下更高的客观PSNR质量往往并不意味着更好的主观视觉质量,对高频分量的丢弃进一步加重了图像纹理细节的缺失,使图像更加模糊,不仅降低了图像的感知质量,而且物体细节的丢失给机器任务的分析也造成了极大的干扰。

PCA是一种数据降维方法,它通过数据特征空间的转换,利用少数互不相关的主成分来尽可能多地反映原始数据信息,去除原始数据间的冗余。由于水下场景比较单一,图像间具有一定的相似性,PCA可通过其特征聚类的优势对相似场景下的水下图像进行有效的压缩。

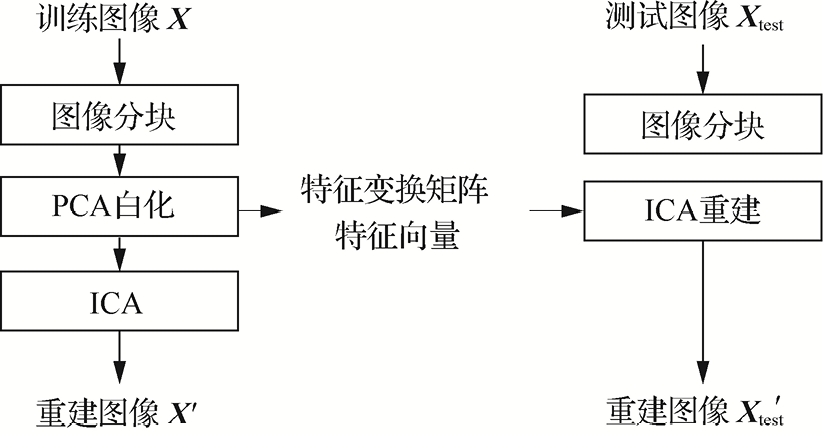

Wang等人提出了一种基于独立成分分析(Independent Component Analysis,ICA)的水下图像压缩算法。ICA 是 PCA 的扩展,可更好地实现对未知数据的降维。该算法主要利用不同水下图像之间存在的相似性,通过提取图像之间共有的特征信息来表示其他水下图像,以此实现图像数据的压缩[30]。该算法的大致流程如图1.4所示,它首先利用训练集图像进行迭代优化,得到适用于水下图像的特征变换矩阵和特征向量等信息;然后只需要对这些数据进行编码传输,即可利用固定数量的特征向量重建出质量较好的测试集图像。

Monika等人利用压缩感知(Compressive Sensing,CS)技术首先对水下图像进行压缩、稀疏采样,然后进行了重建。然而,与基于PCA的压缩算法相似,这类算法的压缩性能并不理想,依然存在图像模糊、细节丢失甚至重建错误的现象,同时其泛化性也较差,只能应用于特定的水下场景[31]。

图1.4 基于ICA的水下图像压缩算法的大致流程

深度学习由于其强大的数据拟合和表征能力,越来越受到各个领域研究人员的关注。深度学习依靠数据驱动,通过非线性拟合等方法来提取并表示数据特征,能够很好地替代传统手工特征,其中应用最广泛的是 CNN。由于 CNN具有部分感知、权值共享、可端到端训练等优势,基于 CNN 的图像压缩算法不断涌现,并且其各类评价指标均接近甚至超过传统压缩编解码器。

对于水下场景,基于 CNN的水下图像压缩算法还少被提及。Krishnaraj等人将适用于普通大气自然图像的 CNN 编解码器迁移至水下图像,取得了不错的实验效果,且与JPEG、JPEG 2000相比有较大优势,但其并没有针对水下图像的特点以及带宽限制对压缩算法做进一步改进[32]。

Zhuang等人提出了一种具有鲁棒性的水下图像低码率压缩网络,该算法的思想与基于小波变换的压缩算法相似,即先将图像转换到YUV颜色空间后再对其进行分别处理。该算法包括两个并行的CNN编码器,分别对Y通道和UV通道的数据进行压缩,得到的码流被合并后经一个CNN解码器对图像进行重建。其中,Y通道数据所占码率比例较大,UV通道数据所占码率比例较小,即在有限码率的条件下较大限度地保留了亮度信息,以满足人眼视觉需求[33]。此外,该算法在训练时还在比特传输过程中引入了随机比特误码来模拟水下信道的不稳定性,以此保证在实际应用过程中的鲁棒性。该算法在低码率下的压缩性能与BPG相当,明显优于JPEG和JPEG 2000。与其他用于大气自然图像的CNN压缩模型相比,该算法在水下图像的压缩上也有一定的性能优势和适用性。Liu等人在此基础上将感知质量引入模型的训练过程,一定限度地提高了重建图像的人眼感知质量[34]。

Monika等人提出了基于水下图像的压缩感知技术。由于水下图像在内容分布上与地面图像相比更简单,因此采样需要集中于信息更多的图像块,即在总体采样率给定的前提下,包含信息多的图像块(如潜水员、鱼类等)使用密度更高的随机高斯矩阵,包含信息少的(如珊瑚、海水等)则采用低密度矩阵,这样可以保留尽可能多的信息。然而,该技术仅改变了图像块中采样点的个数,具体采样位置依旧无法根据内容进行自适应,因而造成了部分采样点的浪费。此外,该技术采用的重建算法是正交匹配追踪(Orthogonal Matching Pursuit,OMP)算法,这是一种传统的数学迭代求解算法,重建性能差且复杂度很高,并不能满足实际的使用需求[35]。

为了评价水下图像增强算法的性能好坏,水下图像增强技术采用了一系列的图像质量评价指标对增强结果进行评估。现有的水下图像质量评价指标可以分为主观评价和客观质量评价指标两大类。其中,主观评价是从人的主观角度出发,依靠人眼主观视觉去评价图像的质量。客观质量评价指标是对人类视觉感知系统进行数学建模,最后得到一个数字量化的评价结果。自然图像质量评价和水下图像质量评价算法主要有全参考(Full Reference,FR)、半参考(Reduced Reference,RR)、无参考(No Reference,NR)3种。

现有的自然彩色图像质量评价算法大多数是针对大气中的图像设计的,其中包括许多全参考图像质量评价算法与无参考图像质量评价算法。截至本书成稿之日,应用较广泛的全参考图像质量评价算法有均方误差(Mean Square Error,MSE)算法、PSNR算法和结构相似性(Structural Similarity,SSIM)算法;现有研究提出的评估自然图像的无参考质量评价算法主要可以分为两大类,即基于传统机器学习的算法和基于深度学习的算法。

基于传统机器学习的算法广泛使用自然场景统计(Natural Scene Statistic,NSS)特征。NSS是指无失真图像的视觉特征(如亮度、色度等)服从一定的分布规律,而不同类型或不同程度的失真会对这些规律产生相应的影响。基于此,Mittal等人用空域下的NSS特征构建了无参考图像质量评价模型(Blind/Referenceless Image Spatial Quality Evaluator,BRISQE),通过局部亮度归一化系数来量化失真图像的质量。同年,Mittal等人提取了图像的空域NSS特征,并将图像分块以提取锐利区域特征,最终提出了自然图像质量评价模型(Natural Image Quality Evaluator,NIQE)[36]。Panetta等人为彩色图像的RGB通道分配权重,提出了由色度、清晰度和对比度构成的无参考彩色图像质量评价模型(Color Quality Enhancement,CQE)[37]。

基于深度学习的算法则通过深度学习解决一些具体的图像质量评价问题。例如,孪生网络(Siamese Network)和排序网络(Sorting Network)被设计用于学习图像间的质量排序信息;在大型图像分类数据集ImageNet中经过预训练的深度卷积神经网络(AlexNet)和残差网络(ResNet)则包含非常丰富的图像内容信息,这些信息与图像的质量有着紧密的联系。例如,针对去雨图像的质量评价,Wu等人提出了一种双向特征嵌入网络(Bi-directional Feature Embedding Network,B-FEN)来定量感知其中的区域不一致伪影[38]。另外,GAN也被用于通过生成参考图像来评价目标图像的质量。

上述图像质量评价算法被设计用于评价大气中自然彩色图像的质量。考虑到水下环境独特的光线吸收与散射的特性,上述算法及对应的指标不能直接被用于评价水下图像的质量。

水下图像质量评价在水下图像研究中有着举足轻重的地位,因此急需可靠的质量评价算法来对增强图像的质量进行评价,以衡量各类增强算法的性能。现有的水下图像质量评价算法均为基于物理的图像质量评价算法,即通过手工提取特征并使用机器学习回归的方式来评价水下图像质量。

截至本书成稿之日,公开的水下图像质量评价算法主要包括 UCIQE、UIQM、CCF和NUIQ。这些算法从图像的颜色、对比度、饱和度等方面提取特征并将其回归成质量分数。

Yang等人提出的水下图像质量评价算法UCIQE[39]考虑到水下图像具有低饱和度、低对比度及颜色失真等问题,因此测量了图像的色度、饱和度及对比度。UCIQE算法手工提取这3个方面的特征,并通过回归计算得到图像的质量分数。

Panetta等人提出了UIQM算法[40]。它包括图像的3个指标:色彩指标、清晰度指标和对比度指标。这3个指标的权重系数通过对训练图像数据进行机器学习回归得到。UIQM算法更注重一张图像整体的色彩与清晰度,这意味着一张清晰、色彩鲜艳的图像将获得较高的得分。

Wang等人提出了一种面向水下图像的质量评价算法,并将其命名为CCF。CCF算法为颜色指标、对比度指标、雾浓度指标的加权融合。其中,颜色指标用于评价水下图像中光吸收导致的色偏问题,对比度指标和雾浓度指标用于评价水下图像中光散射导致的模糊问题[41]。

Jiang等人提出了首个水下真实图像质量评价数据集SAUD,并在该数据集的基础上,提出了无参考水下图像质量评价算法NUIQ[42]。该算法首先分别从图像的色度分量与亮度分量中提取质量感知特征,然后通过训练SVMrank模型进行预测。该算法可用来评价图像中色偏、亮度不理想,以及图像模糊和细节丢失的问题。

上述算法都基于特征的手工提取与回归对水下图像进行质量评价。它们只注重水下图像中原本存在的失真(色偏与模糊),却忽略了水下增强图像中可能存在的过增强、结构损失等失真。这些失真由各种图像增强算法引入,同样严重影响着水下增强图像的质量。因此,现有水下图像质量评价算法的结果被指出与人类视觉感知系统的相关性较差,并不能直接反映图像的主观视觉质量。因此在水下图像增强领域,研究人员仍然会采取主观评价的方法来衡量一张增强后水下图像的视觉感知质量。但是,该方法需要消耗大量的人力和物力,在面对大规模的图像库时显得尤为乏力。因此,研究适合评价水下图像质量增强的算法刻不容缓。

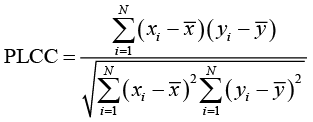

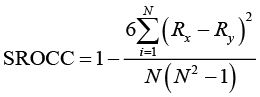

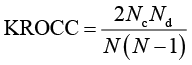

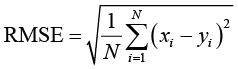

本章涉及的针对图像质量评价算法的性能评价指标主要有:皮尔逊线性相关系数(Pearson Linear Correlation Coefficient,PLCC)、斯皮尔曼等级相关系数(Spearman Rank Order Correlation Coefficient,SROCC)、肯德尔等级相关系数(Kendall Rank Order Correlation Coefficient,KROCC)、均方根误差(Root Mean Square Error,RMSE)、感知权重排序相关度(Perceptually Weighted Rank Correlation,PWRC)。这些指标被用于在绝大多数实验中衡量图像质量评价算法的性能。

PLCC、SROCC、KROCC、RMSE可以反映质量评价算法的客观预测分数和平均主观分数(Mean Opinion Score,MOS)之间的相关性,分别如式(1.1)~式(1.4)所示。

(1.1)

(1.1)

其中, 和

和 分别表示第

分别表示第 张图像的客观预测分数和MOS,

张图像的客观预测分数和MOS, 和

和 分别表示所有

分别表示所有 的平均值和

的平均值和 的平均值,N表示图像的数量。PLCC越大,说明质量评价算法的性能越优异。

的平均值,N表示图像的数量。PLCC越大,说明质量评价算法的性能越优异。

(1.2)

(1.2)

其中, 和

和 分别表示第

分别表示第 张图像的客观预测分数和MOS在数组

张图像的客观预测分数和MOS在数组 、

、 分别按从大到小排序后在数组中的位置。SROCC越大,说明质量评价算法的性能越优异。

分别按从大到小排序后在数组中的位置。SROCC越大,说明质量评价算法的性能越优异。

(1.3)

(1.3)

其中, 表示数据集中一致对(指变量大小顺序相同的两个样本观测值,即

表示数据集中一致对(指变量大小顺序相同的两个样本观测值,即 等级高低顺序与

等级高低顺序与 等级高低顺序相同,否则称为不一致对)的个数,

等级高低顺序相同,否则称为不一致对)的个数, 表示数据集中不一致对的个数。KROCC越大,说明质量评价算法的性能越优异。

表示数据集中不一致对的个数。KROCC越大,说明质量评价算法的性能越优异。

(1.4)

(1.4)

其中, 和

和 分别表示第

分别表示第 张图像的客观预测分数和MOS。RMSE越小,说明质量评价算法的性能越优异。

张图像的客观预测分数和MOS。RMSE越小,说明质量评价算法的性能越优异。

PWRC用于比较质量评价算法与主观感知偏好结果的相关性。通过修改感官阈值,它可以用复杂的SA-ST曲线来表述排序精度,而不是简单的秩相关系数。PWRC越大,说明质量评价算法在该阈值处与感知偏好结果越一致。

随着近年来深度学习技术及相关网络模型的发展,针对各种机器视觉任务的神经网络算法不断涌现,如用于分类任务的VGG和ResNet、用于目标检测任务的Faster R-CNN和YOLO系列、用于分割任务的DeepLab系列等。这类算法依靠大数据的驱动使相应机器任务的分析性能实现了极大的提升,被越来越广泛地应用于相关智能系统。随着海洋水下场景研究的深入,研究人员近几年也开始将这类算法迁移到水下,设计了多种适用于水下图像的机器分析算法,并有较好的性能表现。在实际应用中,这类机器视觉任务的部署方式主要有两种:第一种是将算法部署在接收端,对前端采集的图像数据(经压缩传输后)进行机器分析;第二种是将整个算法或一部分算法部署在前端设备,直接对采集的数据进行分析,并对分析结果或中间特征数据进行压缩传输。

对于第二种方式,机器视觉任务直接用于原始图像,无须考虑压缩失真带来的影响,且计算复杂度更小,更适用于水下中长距离通信系统。对于大部分机器分析算法,其网络模型结构可分为网络主干和分类器两部分,其中网络主干用于任务相关特征的提取,分类器则负责进一步识别、分析网络主干输出的特征。考虑到前端移动设备有限的计算资源,通常将算法模型主干部署在前端设备,分类器部署在接收端,因此中间特征数据的压缩传输性能对水下机器视觉十分重要。与原始图像相比,中间特征数据的空间分辨率往往较小,但其通道数量较多,因此其数据量有增无减,需要对其先进行高效、合理的压缩后再传输。然而,大部分常见的压缩算法都是针对图像数据进行压缩,并不适用于神经网络的中间特征。此外,若要满足多类机器任务的需求,需要首先将多种算法的主干均部署到前端设备,并行(或依次)对图像数据进行分析;然后对多个中间特征数据进行传输,这会对计算资源造成极大的负担。

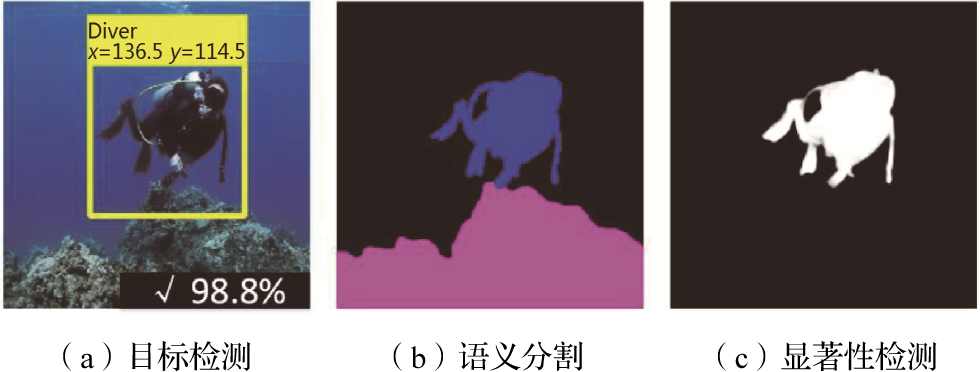

针对水下图像的机器分析在水下环境探测和监测等任务中必不可少,其分析结果可有助于水下机器人的自动巡航、异常处理等操作。下面主要介绍水下目标检测、水下语义分割和水下显著性检测这3类机器视觉任务及其对应的评价指标。

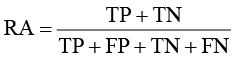

水下目标检测任务是目前水下场景应用最多的机器视觉任务。依靠大气自然图像目标检测算法的快速发展,近年来水下目标检测相关工作也不断涌现,实现了对水下各类目标快速且精准的识别检测,如鱼类的检测和追踪,海参、海胆等小目标的检测,潜水员的检测和自主跟随,以及海洋垃圾检测等。图1.5所示为3种水下机器视觉任务示意图。图1.5(a)所示的水下目标检测算法可对目标位置进行标注,输出目标检测框的坐标和置信度等信息。根据置信度阈值可将检测结果分为4种,见表1.1。其中,TP(True Positive)表示真实结果包含目标,预测结果正确检出目标;TN(True Negative)表示真实结果未包含目标,预测结果未检出目标;FP(False Positive)表示真实结果未包含目标,预测结果错检出目标;FN(False Negative)表示真实结果包含目标,预测结果未检出目标。

图1.5 3种水下机器视觉任务示意图

表1.1 依据置信度阈值对检测结果的划分

| 实际结果 |

检测结果 |

|

|---|---|---|

| 正确 |

错误 |

|

| 正确 |

TP |

FN |

| 错误 |

FP |

TN |

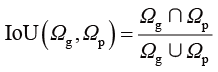

本节主要介绍识别准确率(Recognition Accuracy,RA)、平均精度(Average Precision,AP)和平均召回率(Average Recall,AR)这3个评价指标,同时采用更丰富的交并比(Intersection over Union,IoU)体现检测模型的定位能力。

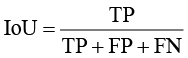

对于样本框,匹配检测框的IoU定义为

(1.5)

(1.5)

其中, 和

和 分别为样本框面积和检测框面积。

分别为样本框面积和检测框面积。

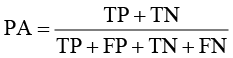

RA表示预测正确的检测框在所有预测结果中所占的比例:

(1.6)

(1.6)

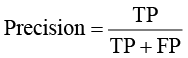

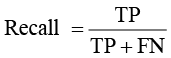

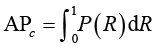

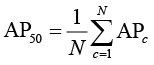

AP可以通过精度-召回率曲线(Precision-recall Curve,PRC)来计算。通过设置不同的置信度阈值,可以得到多个精度-召回率集并绘制曲线。某一类别c的精度( )和召回率(

)和召回率( )为

)为

(1.7)

(1.7)

(1.8)

(1.8)

某一类别c的平均精度( )是PRC下的面积,其表达式为

)是PRC下的面积,其表达式为

(1.9)

(1.9)

表示当IoU阈值为0.5时,所有分类的平均

表示当IoU阈值为0.5时,所有分类的平均 ,其表达式为

,其表达式为

(1.10)

(1.10)

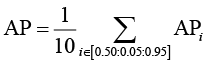

通过设置不同的IoU阈值,可以得到不同的 值。COCO数据集使用的IoU阈值区间为[0.50,0.95],以0.05的步长对10个阈值进行采样,计算10个阈值下的AP并取平均值。因此,最终的AP为

值。COCO数据集使用的IoU阈值区间为[0.50,0.95],以0.05的步长对10个阈值进行采样,计算10个阈值下的AP并取平均值。因此,最终的AP为

(1.11)

(1.11)

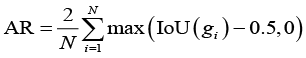

是在每张图像中检测到固定数量框的最大召回率,平均值是根据IoU和类别计算的。

是在每张图像中检测到固定数量框的最大召回率,平均值是根据IoU和类别计算的。 与提案评估(Proposal Evaluation)中使用的指标相关,但是按类别计算的,表达式为

与提案评估(Proposal Evaluation)中使用的指标相关,但是按类别计算的,表达式为

(1.12)

(1.12)

其中, 是样本

是样本 和最近检测框之间的IoU,N是自定义的最大检测数量。

和最近检测框之间的IoU,N是自定义的最大检测数量。

语义分割可对图像中的不同物体进行像素级的识别,从而更加精确地标示各类目标的具体位置,在水下场景中也十分重要。目前,水下语义分割一般可较好地实现对少数语义类别的分割,Islam等人[43]提出的SUIM数据集包含8种语义类别,为水下语义分割的发展起到了促进作用。

水下语义分割的效果如图1.5(b)所示,彩色表示不同类别的物体,其评价指标主要有IoU和像素准确率(Pixel Accuracy,PA)。IoU是预测区域和实际标签区域的交集和并集之比,计算方式表示为

(1.13)

(1.13)

其中,各个参数均为像素级。语义分割通常需要对多种语义类别进行识别,因此往往会计算多种类别的平均IoU(mean IoU,mIoU)。

PA与目标检测中的RA相似,前者计算的是像素级的准确率,其计算方法为

(1.14)

(1.14)

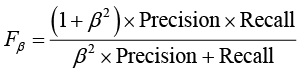

水下显著性检测旨在对图像中的人眼感兴趣的区域进行像素级检测,目前在水下领域也有较多应用,其检测效果如图1.5(c)所示。水下目标检测和水下语义分割的评价指标也可用于该检测任务的评价,除此之外,S值( )和F值(

)和F值( )也是常用的评价指标。

)也是常用的评价指标。 是对检测显著性图与标签之间结构相似度的度量。

是对检测显著性图与标签之间结构相似度的度量。 是对精度和召回率的加权平均:

是对精度和召回率的加权平均:

(1.15)

(1.15)

其中, 通常取0.3。

通常取0.3。

本章首先阐述了海洋水下成像和压缩传输研究的背景和意义,并介绍了海洋水下成像与压缩传输系统,随后对该系统涉及的关键技术进行了说明,介绍了各关键技术的代表性方法、研究现状以及在应用时的需求和尚待解决的问题。我国海洋水下成像研究亟待探索融入水下光声图像特点和水声传输等因素的成像与处理技术,实现海洋信息数据“传得快”“看得清”、服务于“测得准”,在“海洋信息获取和传输”领域内形成突破,转化一批具有自主知识产权的技术和装备,形成我国在海洋水下成像与压缩传输的技术优势,促进海洋探测和海洋观测等高技术产业的发展。

[1] IQBAL K, SALAM R A, OSMAN A, et al. Underwater image enhancement using an integrated colour model[J]. IAENG International Journal of Computer Science, 2007, 34(2): 1-8.

[2] FU X, FAN Z, LING M, et al. Two-step approach for single underwater image enhancement[C]// Proceedings of 2017 International Symposium on Intelligent Signal Processing and Communication Systems (ISPACS). NJ: IEEE, 2017: 789-794.

[3] ANCUTI C, ANCUTI C O, HABER T, et al. Enhancing underwater images and videos by fusion[C]// Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . [S. l.]: [s. n.], June 2012: 81-88.

[4] ANCUTI C O, ANCUTI C, DE VLEESCHOUWER C, et al. Color balance and fusion for underwater image enhancement[J]. IEEE Transactions on Image Processing. NJ: IEEE, 2017, 27(1): 379-393.

[5] HITAM M S, AWALLUDIN E A, YUSSOF W N J H W, et al. Mixture contrast limited adaptive histogram equalization for underwater image enhancement[C]// Proceedings of 2013 International Conference on Computer Applications Technology (ICCAT). [s. l.]: [s. n.], 2013: 1-5.

[6] FU X, ZHUANG P, HUANG Y, et al. A retinex-based enhancing approach for single underwater image[C]// Proceedings of 2014 IEEE International Conference on Image Processing (ICIP). NJ: IEEE, 2014: 4572-4576.

[7] JAFFE J S. Computer modeling and the design of optimal underwater imaging systems[J]. IEEE Journal of Oceanic Engineering, 1990, 15(2): 101-111.

[8] DREWS P L J, NASCIMENTO E R, BOTELHO S S C, et al. Underwater depth estimation and image restoration based on single images[J]. IEEE Computer Graphics and Applications, 2016, 36(2): 24-35.

[9] CHIANG J Y, CHEN Y C. Underwater image enhancement by wavelength compensation and dehazing[J]. IEEE Transactions on Image Processing, 2011, 21(4): 1756-1769.

[10] GALDRAN A, PARDO D, PICÓN A, et al. Automatic red-channel underwater image restoration[J]. Journal of Visual Communication and Image Representation, 2015, 26: 132-145.

[11] LI C Y, GUO J C, CONG R M, et al. Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior[J]. IEEE Transactions on Image Processing, 2016, 25(12): 5664-5677.

[12] PENG Y T, COSMAN P C. Underwater image restoration based on image blurriness and light absorption[J]. IEEE Transactions on Image Processing, 2017, 26(4): 1579-1594.

[13] AKKAYNAK D, TREIBITZ T. Sea-thru: a method for removing water from underwater images[C]// Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). NJ: IEEE, 2019: 1682-1691.

[14] BERMAN D, LEVY D, AVIDAN S, et al. Underwater single image color restoration using haze-lines and a new quantitative dataset[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(8): 2822-2837.

[15] WANG Y, ZHANG J, CAO Y, et al. A deep CNN method for underwater image enhancement[C]// Proceedings of 2017 IEEE International Conference on Image Processing (ICIP). NJ: IEEE, 2017: 1382-1386.

[16] LI C, ANWAR S, PORIKLI F. Underwater scene prior inspired deep underwater image and video enhancement[J]. Pattern Recognition, 2020, 98: 107038.

[17] DUDHANE A, HAMBARDE P, PATIL P, et al. Deep underwater image restoration and beyond[J]. IEEE Signal Processing Letters, 2020, 27: 675-679.

[18] WANG K, HU Y, CHEN J, et al. Underwater image restoration based on a parallel convolutional neural network[J]. Remote Sensing, 2019, 11(13): 1591.

[19] ZHOU Y, YAN K, LI X. Underwater image enhancement via physical-feedback adversarial transfer learning[J]. IEEE Journal of Oceanic Engineering, 2022, 47(1): 76-87.

[20] WANG K, SHEN L, LIN Y, et al. Joint iterative color correction and dehazing for underwater image enhancement[J]. IEEE Robotics and Automation Letters, 2021, 6(3): 5121-5128.

[21] LI C, GUO C, REN W, et al. An underwater image enhancement benchmark dataset and beyond[J]. IEEE Transactions on Image Processing, 2019, 29: 4376-4389.

[22] FABBRI C, ISLAM M J, SATTAR J. Enhancing underwater imagery using generative adversarial networks[C]// Proceedings of 2018 IEEE International Conference on Robotics and Automation (ICRA). NJ: IEEE, 2018: 7159-7165.

[23] ISLAM M J, XIA Y, SATTAR J. Fast underwater image enhancement for improved visual perception[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 3227-3234.

[24] LI C, GUO C, REN W, et al. An underwater image enhancement benchmark dataset and beyond[J]. IEEE Transactions on Image Processing, 2019, 29: 4376-4389.

[25] HU J, JIANG Q, CONG R, et al. Two-branch deep neural network for underwater image enhancement in HSV color space[J]. IEEE Signal Processing Letters, 2021, 28: 2152-2156.

[26] LI C, GUO J, GUO C. Emerging from water: underwater image color correction based on weakly supervised color transfer[J]. IEEE Signal Processing Letters, 2018, 25(3): 323-327.

[27] HE Y, BU X, JIANG M, et al. Low bit rate underwater video image compression and coding method based on wavelet decomposition[J]. China Communication, 2020, 17(9): 210-219.

[28] ZHANG Y, NEGAHDARIPOUR S, LI Q. Low bit-rate compression of underwater imagery based on adaptive hybrid wavelets and directional filter banks[J]. Signal Processing Image Communication, 2016, 47: 96-114.

[29] ZHANG Y, LI Q Z, NEGAHDARIPOUR S. Seafloor image compression using hybrid wavelets and directional filter banks[C]// Proceedings of MTS/IEEE OCEANS. NJ: IEEE, 2015: 1-9.

[30] WANG J, HE B, ZHANG S, et al. An efficient digital image compression scheme based on ICA for underwater color images[C]// Proceedings of MTS/IEEE OCEANS. NJ: IEEE, 2014: 1-4.

[31] MONIKA R, SAMIAPPAN D, KUMAR R. Underwater image compression using energy based adaptive block compressive sensing for IoUT applications[J]. Visual Computing, 2020(4).

[32] KRISHNARAJ N, ELHOSENY M, THENMOZHI M, et al. Deep learning model for real-time image compression in internet of underwater things (IoUT)[J]. Journal of Real-Time Image Processing, 2020, 12(4).

[33] ZHUANG M, LUO Y, DING X, et al. A robustness and low bit-rate image compression network for underwater acoustic communication[C]// Proceedings of International Conference on Neural Information Processing. [s. l.]: [s. n.], 2019:106-116.

[34] LIU J, YUAN F, XUE C, JIA Z, et al. An efficient and robust underwater image compression scheme based on autoencoder[J]. IEEE Journal of Oceanic Engineering, 2023:1-21.

[35] MONIKA R, SAMIAPPAN D, KUMAR R. Underwater image compression using energy based adaptive block compressive sensing for IoUT applications[J]. The Visual Computer. 2021, 37(4).

[36] MITTAL A, MOORTHY A K, BOVIK A C. No-reference image quality assessment in the spatial domain[J]. IEEE Transactions on Image Processin, 2012, 21(12): 4695-4708.

[37] PANETTA K, GAO C, AGAIAN S. No reference color image contrast and quality measures[J]. IEEE Transactions on Consumer Electronics, 2013, 59(3):643-651.

[38] WU Q, WANG L, NGAN K N, et al. Subjective and objective de-raining quality assessment towards authentic rain image[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020, 99:1-1.

[39] YANG M, SOWMYA A, et al. An underwater color image quality evaluation metric[J]. IEEE Transactions on Image Processing, 2015, 24(12): 6062-6071.

[40] PANETTA K, GAO C, AGAIAN S. Human-visual-system-inspired underwater image quality measures[J]. IEEE Journal of Oceanic Engineering, 2016, 41(3):541-551.

[41] WANG Y, LI N, LI Z, et al. An imaging-inspired no-reference underwater color image quality assessment metric[J]. Computers & Electrical Engineering, 2018, 70: 904-913.

[42] JIANG Q, GU Y, LI C, et al. Underwater image enhancement quality evaluation: benchmark dataset and objective metric[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2022: 5959-5974.

[43] ISLAM M J, EDGE C, XIAO Y, et al. Semantic segmentation of underwater imagery: dataset and benchmark[C]// IEEE International Conference on Intelligence Robots and Systems. NJ: IEEE, 2020:1769-1776.