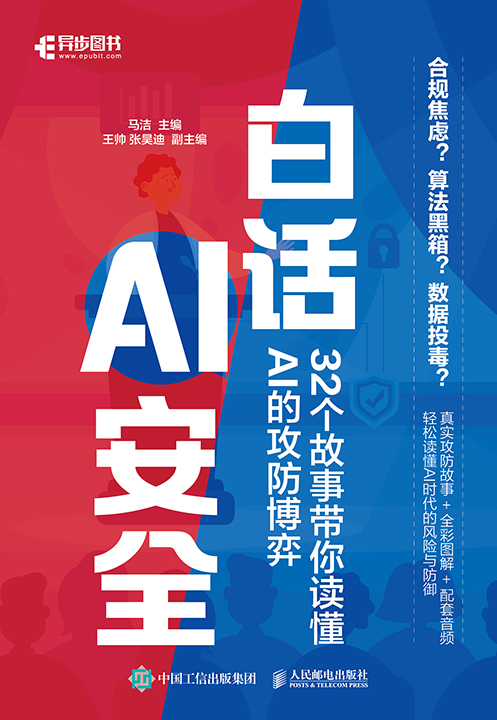

书名:白话AI安全:32个故事带你读懂AI的攻防博弈

ISBN:978-7-115-68267-3

本书由人民邮电出版社发行数字版。版权所有,侵权必究。

您购买的人民邮电出版社电子书仅供您个人使用,未经授权,不得以任何方式复制和传播本书内容。

我们愿意相信读者具有这样的良知和觉悟,与我们共同保护知识产权。

如果购买者有侵权行为,我们可能对该用户实施包括但不限于关闭该帐号等维权措施,并可能追究法律责任。

主 编 马 洁

副 主 编 王 帅 张昊迪

责任编辑 单瑞婷

人民邮电出版社出版发行 北京市丰台区成寿寺路11号

邮编 100164 电子邮件 315@ptpress.com.cn

网址 http://www.ptpress.com.cn

读者服务热线:(010)81055410

反盗版热线:(010)81055315

随着AI技术深度融入医疗、金融、交通等关键领域,其安全风险已从技术问题升级为关乎社会稳定与伦理的核心挑战。本书以通俗易懂的“故事+对话”形式,揭开AI安全的神秘面纱,以“AI的攻防博弈”为主线,通过32个故事系统剖析AI时代的核心挑战和解决方案。

本书分为五篇,旨在帮助读者构建AI安全认知体系。第一篇从AI泄露用户隐私、AI应用技术风险等案例切入,揭示AI安全的重要性,勾勒攻防战场全貌;第二篇聚焦技术与管理双重维度,深入模型鲁棒性、可解释性差、数据质量与数据投毒等九大核心问题,探讨技术漏洞背后的伦理与法律困境;第三篇详解对抗样本、模型窃取攻击等十一类攻击手法,并给出对抗训练、可解释性工具等防护方案;第四篇展示AI如何赋能安全,包括安全大模型、AI代码审计工具等,以及电信运营商实践案例;第五篇聚焦AI安全行业动态与未来发展趋势,展望AI安全在标准规范、产业研究方向的趋势。

本书适合AI行业的技术人员(网络安全从业者、AI工程师)阅读,也适合关注AI合规的企业管理者借鉴,还适合希望系统理解AI安全的高校师生与探索者学习。

马 洁

王 帅 张昊迪

陈 杰 陈怡欣 高培城 苟万婷

胡凯桐 李文灏 马宇飞 任宏丹

汤怡宁 魏小博 张丰露 张 颖

邹金财

李 进 中国电信股份有限公司

金华敏 中国电信研究院

陈百利 广东邮电职业技术学院

李博杰 Logenic AI公司

秦晓磊 中国软件评测中心

林 明 广东工业大学

段海新 清华大学

随着AI应用的普及,越来越多的人体验到AI给我们日常生活带来的便利。然而,便利与隐患并存,技术的演进也揭开了AI时代最尖锐的议题之一:当算法渗透到生活的每个角落,如何有效化解偏见、防范漏洞与风险?

这正是本书试图回答的核心问题。本书以32个故事为脉络,将抽象的AI安全挑战转化为鲜活的生活片段,对话式的叙事风格不仅提出问题,而且层层剖析问题的来源和解决方法。这种由表及里的分析模式,既降低了理解门槛,又保留了专业深度。

本书的编排充分体现了作者的全局视野:从技术挑战(如模型鲁棒性、数据投毒)、伦理困境(如算法歧视、责任归属)到法律合规(如隐私保护、跨国监管),再到攻防实战(如模型窃取与防御、后门攻击及其防护)等,覆盖了AI安全的完整链条。尤为可贵的是,书中在揭露问题的同时,提供了可落地的解决方法,为AI系统的开发者与管理者指明了实践方向。

对希望深入了解AI安全的读者而言,本书的价值在于其平衡性及全面性:既有通俗易懂的故事引导读者思考,又不回避技术细节;既警示风险,又赋能防御。在全球针对AI治理争论不休的当下,本书用“故事+方法论”的组合,绘制了一幅兼具人文关怀与技术理性的安全地图。

翻开本书,你将意识到AI安全不仅是技术问题,更是社会命题。理解AI安全,或许就是我们守护未来AI世界的第一步。

诸葛建伟 博士

2025年6月于北京清华园

谈及AI安全问题,不禁让人联想到《列子·汤问》中一则充满奇幻色彩的故事:周穆王西巡归来时,遇到一位名叫偃师的工匠。偃师主动向他展示了一具亲手制作的人偶。它不仅容貌举止与真人无异,还能歌善舞,以至于周穆王一度以为眼前的是一名真正的活人。更出人意料的是,这人偶后来竟“胆大包天”,频频向周穆王身边的宠妃“暗送秋波”,引得周穆王勃然大怒,欲将偃师处以死罪。偃师情急之下当场将人偶拆解,才证明它并非真人,终得解脱。

这则古老传说,在某种程度上,可视为对AI伦理与安全议题的一种超前隐喻。人们早在千年前就已想象出具备一定自主能力的“人造智能体”,并预见到其可能带来的失控风险——正如当下AI所面临的安全挑战。AI安全问题,是一个跨越技术边界、系统边界、认知边界的新命题。传统信息安全体系以防护静态系统为核心,而AI系统具备学习性与自适应性,拥有高度复杂的黑箱决策机制,不仅影响AI模型本身的安全性,也极易被当作攻击的媒介。同时,在涉及公共治理、社会舆论、金融交易等高风险场景中,AI系统一旦出现偏差或被操控,后果将远比传统技术失控更严重。

随着AI在关键基础设施和公共决策体系中的渗透程度不断加深,其潜在安全影响已不容忽视。在政务、医疗、金融、交通等高风险场景部署的AI,必须具备可验证、可追溯、可控制的安全属性。从模型训练到推理部署,从数据接入到结果输出,每一个环节都必须建立严格的安全边界和技术审查机制。

国家层面对AI安全的关注也在不断深化。国务院印发的《新一代人工智能发展规划》等一系列文件,将“安全可控”确立为AI发展的核心底线,并部署了治理体系与风险评估机制的建设任务。2025年8月,在国务院印发的《关于深入实施“人工智能+”行动的意见》中,也强调“防范模型的黑箱、幻觉、算法歧视等带来的风险”。可以预见,在未来AI快速演化的背景下,AI安全治理将日益走向体系化、制度化与前置化。AI不再是“先发展、后治理”的技术试验田,而是需要“同步设计、安全内嵌”的战略型能力系统。

在AI全面走向现实场景、技术红利逐步释放的关键时刻,本书的出版恰逢其时。作为一本面向大众的AI安全科普著作,本书从技术、产业、社会等多维视角出发,通过深入浅出的解析和贴近生活的故事,介绍了当前AI安全所面临的挑战与应对策略,为公众打开了一扇理解“AI为何必须安全”的认知之窗。这不仅是知识的普及,更是观念的唤醒,为社会各界人士了解、思考并参与AI安全建设提供了良好的途径。本书编委会的巧思与匠心,实属难得。

我们正处在通往智能社会的转折点上。AI的能力越强,安全的责任越重;AI走得越快,对它的控制就必须越早准备、越深度思考。希望本书能成为一次对全社会的理性提醒,让周穆王面对人偶失控的困扰,不再重演于当下及未来的人类社会;也希望有更多具备战略视野与技术厚度的科普著作持续涌现,共同为AI时代筑牢安全防线。

李庆坤

2025年8月于广州

AI已经悄然融入我们的日常生活:手机中的智能助手,视频平台的推荐算法,电商网站的个性化营销,自动驾驶汽车的决策系统,会写诗、作画或编程的“AI创作者”,都是AI的应用。AI不再是科幻小说的主角,而是现实社会中的重要力量,正在以指数级的速度重塑我们所熟知的一切。

然而,所有伟大的技术进步都伴随着新的风险。炫目的AI光环背后,潜藏着越来越多不容忽视的安全隐患。

你是否听说过这些问题:

◆ AI会不会突然失控?

◆ 如何防止AI被黑客利用?

◆ 模型遭到攻击时,我们该如何应对?

◆ AI出现错误时,该由谁来担责?

◆ 我们是否正在构建一个无法完全控制的AI系统?

如果这些疑问曾在你脑海中闪现,那么本书就是为你而写的。

本书是一部面向大众的AI安全入门书,力图在技术与通识之间、前沿与现实之间搭起一座桥梁,让更多人真正理解AI安全的全貌与本质。

我们没有选择用术语堆砌和晦涩表达制造距离感,而采用“故事+对话”的形式,旨在以轻松、生动的方式,带你穿越AI安全的迷雾,从一个个鲜活的案例和场景中,领悟那些看似遥远、实则切身相关的技术与理念。你将看到:

◆ AI是如何崛起的,它的能力有多强,又为何不稳定?

◆ 模型为何像“黑箱”,它的脆弱性究竟来自哪里?

◆ 攻击者如何欺骗AI,防御者又能做些什么?

◆ 伦理、制度如何跟上这场智能革命的步伐?

◆ AI如何赋能安全防御,成为“守护者”而非“威胁者”?

读者无须具备深厚的AI背景,也不必是网络安全专家。本书适合所有对AI安全感兴趣的人,无论是高校学生、科技工作者、企业管理者,还是普通用户、行业观察者。只要你愿意思考“AI是否安全”,本书都能给你带来启发。

AI带来了前所未有的机遇,也带来了前所未有的挑战。它将成为人类的助手,还是变数的源头,在很大程度上取决于我们现在的选择。唯有深入理解安全的本质,积极面对攻防的博弈,才能让AI真正造福人类。

希望本书能够唤起更多人对AI安全的关注,激发更多的思考,推动更多的合作。AI安全,是每一位现代人不可回避的课题。站在AI浪潮中的我们必须去洞察、去防护、去引导,这样才能更好地守护AI安全,让AI更好地为人类服务。

愿本书成为你理解AI安全的起点,也成为你参与构建AI安全的基石。期待与你一同探索这片充满未知与可能的领域,共同守护一个更加安全、可信的智能未来!

本书编委会

2025年6月

本书提供如下资源:

◆ 本书配套音频;

◆ 思考题参考答案;

◆ 本书思维导图;

◆ 异步社区7天VIP会员。

要获得以上资源,您可以扫描下方二维码或书中二维码,根据指引领取。

我们的联系邮箱是shanruiting@ptpress.com.cn。

如果您对本书有任何疑问、建议,或者发现本书中有任何错误,请您发邮件给我们,并请在邮件标题中注明本书书名,以便我们更高效地做出反馈。

如果您有兴趣出版图书、录制教学视频,或者参与图书翻译、技术审校等工作,可以发邮件给我们。

如果您所在的学校、培训机构或企业,想批量购买本书或异步社区出版的其他图书,也可以发邮件给我们。

如果您在网上发现有针对异步社区出品图书的各种形式的盗版行为,包括对图书全部或部分内容的非授权传播,请您将怀疑有侵权行为的链接发邮件给我们。您的这一举动是对作者权益的保护,也是我们持续为您提供有价值的内容的动力之源。

“异步社区”(www.epubit.com)是由人民邮电出版社创办的IT专业图书社区,于2015年8月上线运营,致力于优质内容的出版和分享,为读者提供高品质的学习内容,为作译者提供专业的出版服务,实现作者与读者在线交流互动,以及传统出版与数字出版的融合发展。

“异步图书”是异步社区策划出版的精品IT图书的品牌,依托于人民邮电出版社在计算机图书领域多年的发展与积淀。异步图书面向IT行业以及各行业使用IT技术的用户。

扫码听音频

新学期,小翼选修了一门叫作“AI安全”的课,授课老师是计算机学院里大名鼎鼎的安全专家安教授。

这门课是今年新开的公开课,不仅对本院的学生开放,也欢迎其他学院的学生选修。据说,这门课开放报名的第一天,名额很快就被抢光了,抢到名额的有些是法学院、新闻学院等其他学院的学生,还有几位是拥有企业背景的“社会旁听生”。

教室里座无虚席,有人戴着耳机默默等待,有人手里拿着厚厚一摞AI论文,还有人在讨论着“用户被AI欺骗后泄露验证码”的热搜新闻。看着教室里不同专业、不同年龄、不同学习目的的听众,小翼心生感慨:原来AI安全,真的已经不只是技术圈的事了。

门在此时被轻轻推开。安教授走了进来,步伐沉稳,目光和蔼。他没有立刻点开PPT,只是站在讲台中央,看着台下的同学,同学们立刻安静了下来。

“同学们,欢迎来到AI安全课堂!大家今天坐在这里,是因为我们意识到了一个问题——AI已不再是‘未来技术’,它正深刻影响着当下。”安教授语气平缓,却直指问题的内核。

“AI技术越来越强大,也越来越不可控。它能辅助医生诊断疾病、帮人撰写报告、与人进行对话,甚至帮助系统做出决策。然而,与此同时,它也可能判断失误、遭受恶意操控、泄露敏感信息,甚至在关键时刻触发一系列意料之外的连锁反应。”

他扫视一圈,接着说:“你们可能想知道,为什么AI系统能被‘一句话’引导出错?模型的数据是如何在看不见的地方被悄悄污染的?攻击是怎么发生的?出了问题,该由谁担责?”

他顿了顿,补充道:“昨天上午,我收到了一位学生的求助。事情虽不复杂,但后果却很严重。他朋友的公司推出了一款基于大语言模型的智能客服系统,该系统上线快、效果好,但未经过任何安全审核流程,直接将数据库与用户接口连接。”

“于是上线第三天,就出事了。”

“用户开始收到AI发出的‘密码修改建议’,甚至引导他们主动提供验证码。有人相信并照做了。于是,信息泄露、系统告警、用户投诉接连发生。”

教室里一阵沉默。有人坐直了身,有人手中的笔停了下来。

“这不是因为模型‘变坏了’,而是因为系统没有做应有的限制:没有上下文隔离、没有提示注入防护、没有敏感信息识别机制,甚至将API密钥暴露在前端代码中。它做错了事,但不是因为它‘邪恶’,而是因为它‘顺从’。”

“我们不是输在技术,而是输在了预期之外。”

安教授站在台上,神情淡定,但每一个字都像是在为现实划出边界。

“AI的安全性取决于我们为它设定的边界与限制,如果依然用过去的软件开发思维来治理今天的智能系统,那么安全问题‘防不住、查不明、治不了’的局面将愈发常见。”

他话锋一转,继续说道:“昨天晚上,我们请了一位非计算机科班出身的同学协助排查。他用了一整晚,逐行排查日志、还原模型响应过程、比对接口配置,最终确定模型被引导执行敏感行为的触发链。”

小翼明白,安教授通过这个例子旨在说明一件更重要的事情——AI安全不只是技术任务,更是一种持续的责任。

“所以,这门课不讲代码,也不讲模型结构。”安教授环视全场,“而用真实可感的案例和通俗可懂的语言,把复杂的技术讲明白,把可执行的方法讲出来。”

安教授继续说道:“与此同时,我们也会告诉大家,AI不仅是安全威胁的‘承受者’,更是破局传统安全困境的‘赋能者’,甚至能够让安全运营从‘被动救火’转向‘主动预判’,这是AI时代赋予安全领域的核心变革。”

“我无法让你们一夜之间变成AI安全专家,但希望你们可以通过本课程的学习,获得一把钥匙。”

“这把钥匙,不仅是技术的入门凭证,更是一种思维方式,一种责任感,以及一种对智能社会未来发展的积极参与态度。”

教室里安静得几乎能听见呼吸声,每个人眼中都闪烁着期待的光芒。

AI安全之旅,就此开启。

故事1

故事1

扫码听音频

安教授打开PPT,笑着说:“在聊安全之前,我们先回顾一下AI的发展历史。我想问问大家,你们都知道哪些跟AI有关的事件呢?越早的越好。”

同学们开始七嘴八舌地讨论起来。有人大声说:“2016年,AlphaGo击败了围棋冠军李世石!”另一位同学说:“还有更早的!2011年,苹果发布的iPhone 4S中就有AI语音助手Siri了!”

小翼脑子里浮现出昨天预习的知识,赶忙大声说:“图灵测试才是最早的!”

安教授闻言,微笑着转向小翼:“这位同学,我听到你提到了图灵测试,你能给大家介绍一下吗?”

小翼高兴地站起来介绍说:“图灵测试的概念是1950年提出的。测试过程中,需要与机器进行很多轮对话,如果测试者分辨不出对方是不是真人,就认为机器具有跟人类相似的智慧。总之,图灵测试是衡量计算机通用智慧能力的一种标准。”

安教授认可地点了点头,然后说道:“18世纪60年代,人类发展出了先进的工业文明,机器开始替代工人的部分体力劳动,极大地提高了生产效率。这时,一些人开始忍不住讨论,例如,机器能否像人类一样思考?假设未来人造机器中出现了类似人类的思考能力,人类该如何看待这台机器?”

这一连串的问题让同学们躁动起来。

有同学说:“机器是由人类制造出来的,而不是自然界的生命,所以机器只能是机器。”

有同学不同意这个观点:“这要取决于对意识和人格的定义。如果机器表现出的智慧只是程序设定,缺乏真正的意识和感受,那么应被视为‘机器’。否则,如果机器具备了自我认知、情感和主观感受,那就应该被当作‘人类’。”

一时间,课堂变成了热闹的辩论大会,同学们纷纷各抒己见。

安教授拍了拍手,示意大家安静下来:“其实,就像大家一样,科学家们也很关心这个问题。1956年,一些科学家在美国达特茅斯学院召开研讨会(达特茅斯会议),讨论如何实现计算机编程、计算机自动改进等问题。在这次会议上,首次提出了人工智能(artificial intelligence,AI)概念,后来人工智能泛指任何使计算机模仿人类智能完成指定任务的技术。”

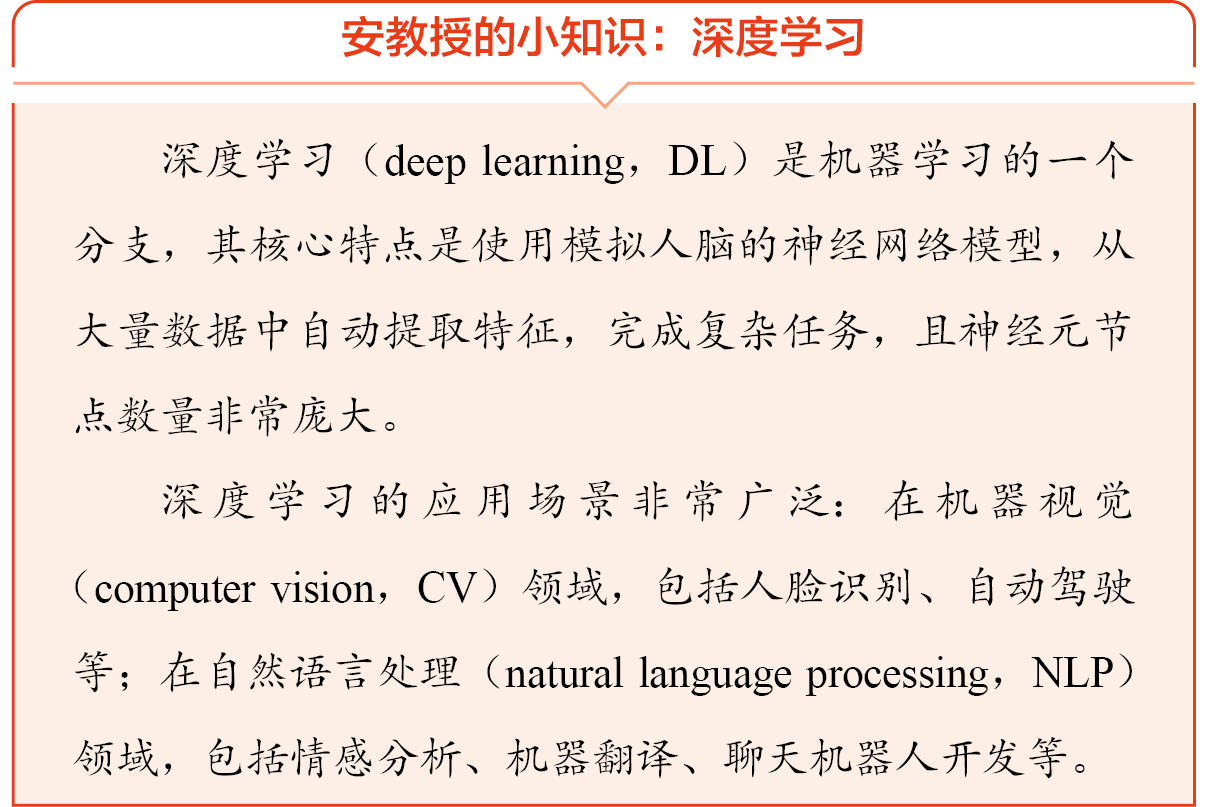

小翼认真地记着笔记,想起预习时看到的“机器学习”和“深度学习”,忍不住问道:“教授,我一直没弄清楚人工智能、机器学习和深度学习的关系,您能讲讲吗?”

“这是一个非常好的问题!”安教授称赞道,“虽然科学家们在达特茅斯会议期间对人工智能有了定义和初步思考,但还不清楚怎么实现。有一些研究者尝试让计算机学习大量数据,通过统计学技术让计算机掌握经验,逐步提升完成任务的能力,这种技术被称为机器学习(machine learning,ML)。它是探索人工智能的一条可行路径。”

小翼又追问:“那深度学习呢?”

安教授接着说:“深度学习是机器学习中的一类技术,不仅让计算机学习大量数据,还使用了模拟人类大脑的神经元结构。神经元之间一层一层连接起来组成网络,所以也被称为深度神经网络。”

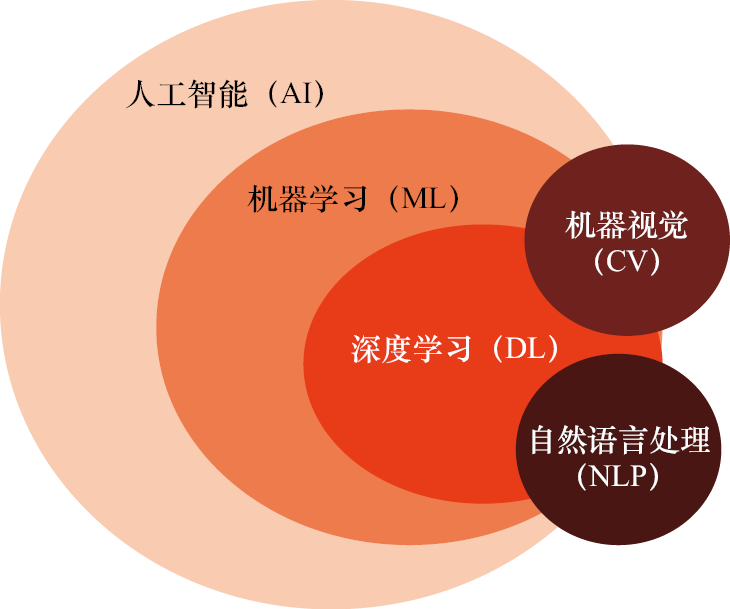

为了帮助大家更好地理解这5个名词的关系,安教授给大家画了张图。

人工智能、机器学习、深度学习、机器视觉和自然语言处理之间的关系

小翼按捺不住好奇心,再一次举手提问:“教授,人工智能的概念是怎么一步步演变成如今的深度学习的呢?”

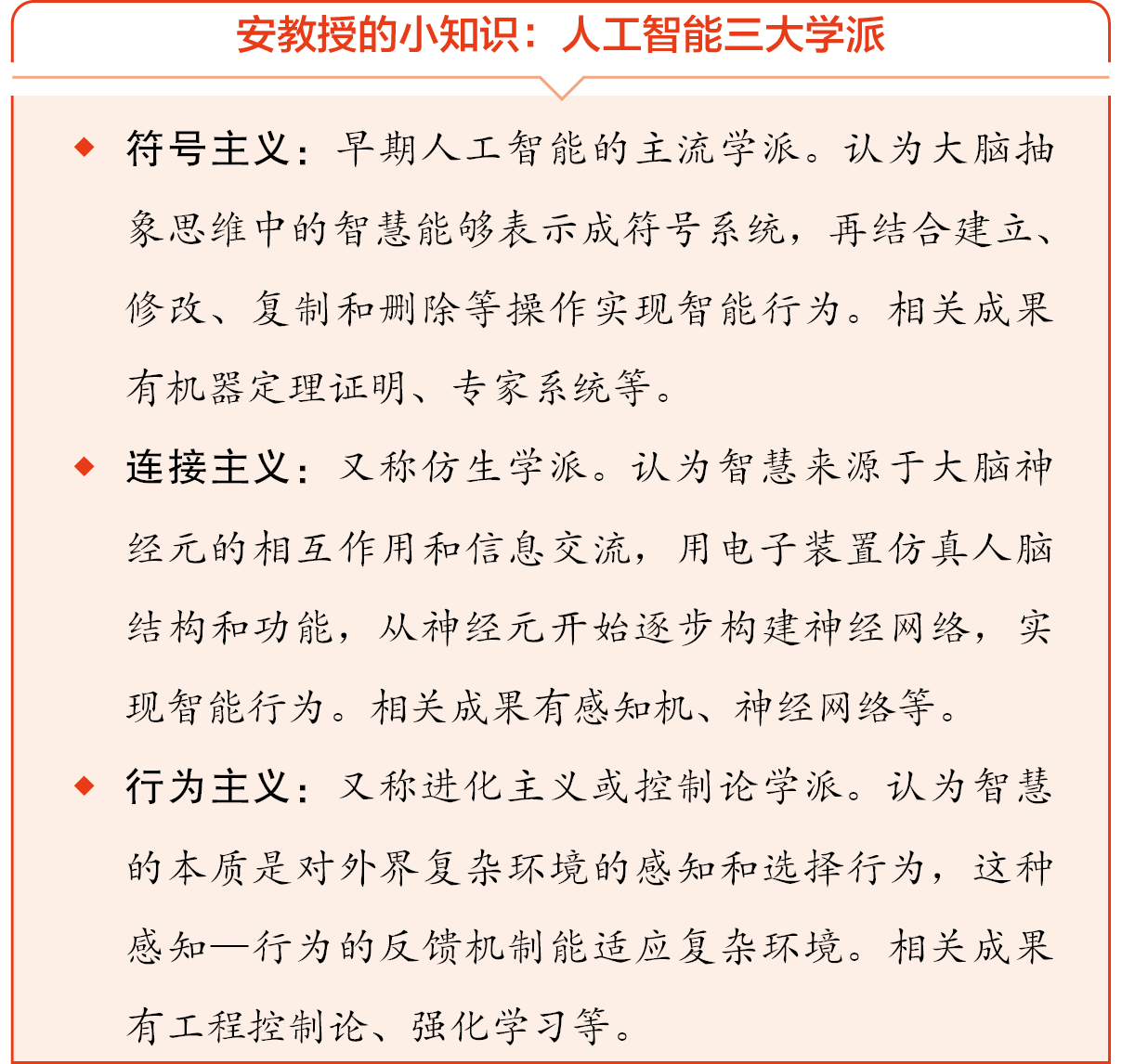

安教授说:“为了实现人工智能,很多研究者前赴后继地展开探索。早期,部分研究者想把人类的思维过程像做数学证明题一样表示出来,他们研发了专家系统,用了很多符号表示大脑的感知、推理、决策等过程。可惜的是,这些研发成果只适用于一些专业领域,还没有‘智能’,这种思路被称作符号主义。”

小翼想了想,说:“符号可以表示人类的科学智慧,但是人类的艺术智慧,比如绘画、音乐和写作等源于灵感的创作,似乎无法用数学公式去推理。”

安教授绕到小翼的身边,拍了拍他的肩膀:“说得很好。有一部分研究者也是像你这样考虑的。他们认为人类的智慧来源于大脑,计算机的智慧也要来源于‘大脑’,于是他们模仿人脑结构和功能设计了人工神经元和人工神经网络,最后逐步发展出了深度学习,这种思路被称作连接主义。于是,基于深度学习的AI模型就有丰富的创作能力了。”

小翼说:“那真是朝着人工智能迈出了一大步呢!”

安教授点了点头,接着说:“还有一批研究者从生物与环境的交互过程中得到启发,通过传感器接收信息,再通过算法处理这些信息并控制下一步动作。他们的研究推动了智能控制系统、智能机器人等领域的发展,这种思路被称作行为主义。”

课堂上,同学们都在认真思考和记录。这时,有一位同学举手问道:“教授,那大模型是怎么研究出来的呢?”

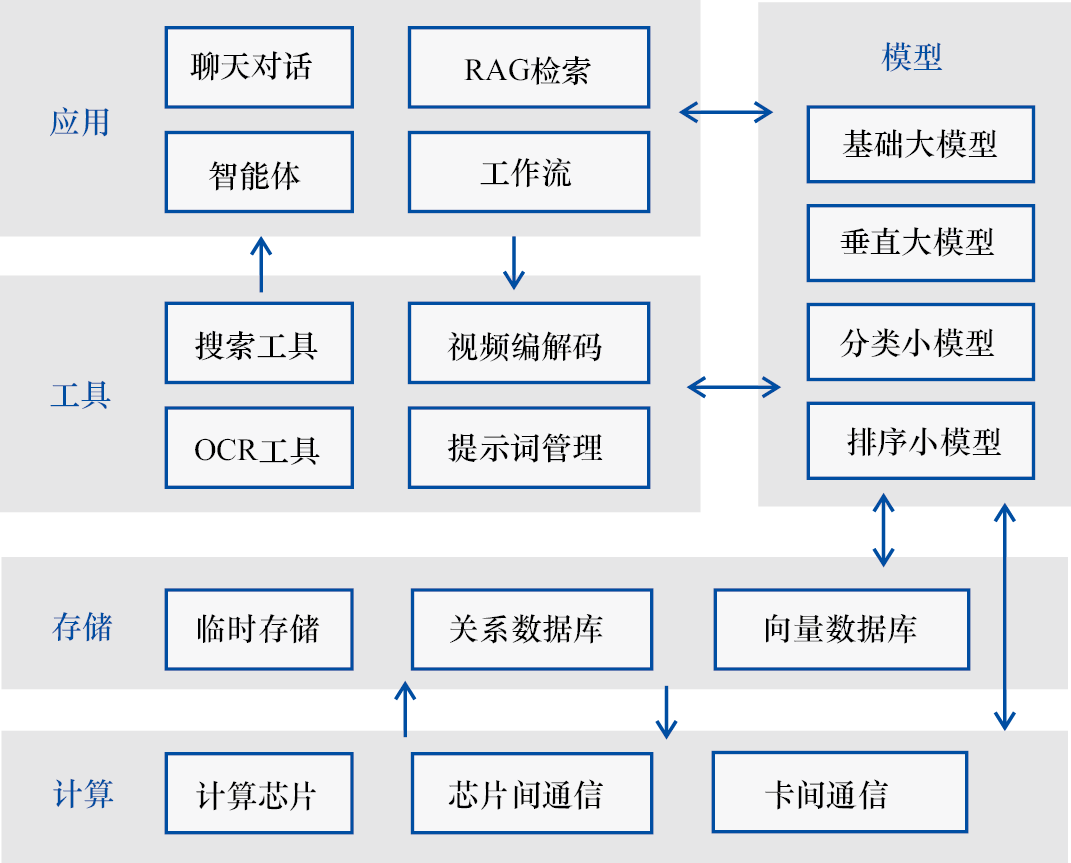

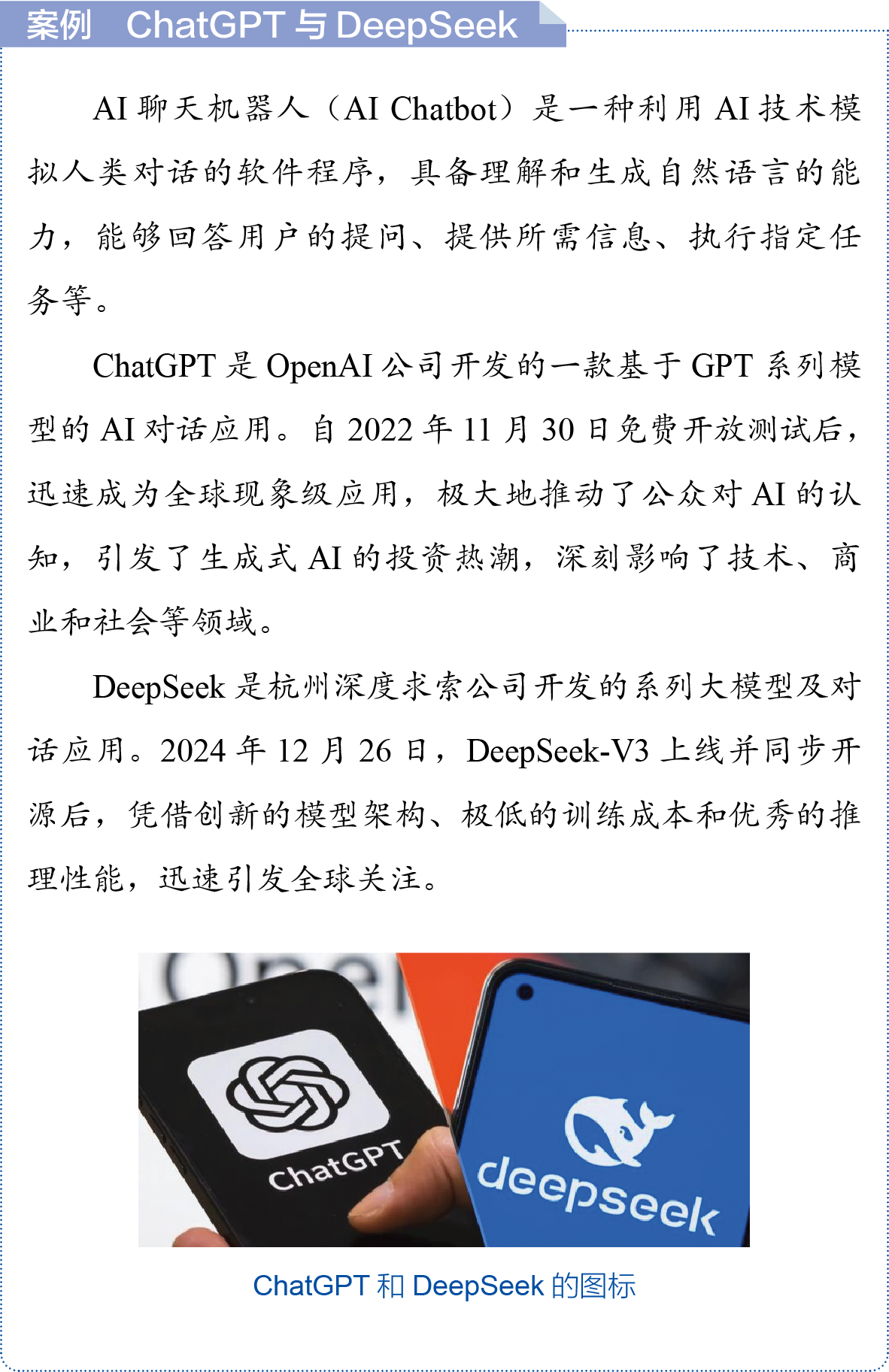

安教授答道:“大模型是过去各种探索的智慧结晶。早在上个世纪,就有众多学者探索机器翻译。后来,随着自然语言处理技术和算力规模的发展,深度学习模型的内在架构发生了许多演进,神经元规模增长到了百亿级别,AI开始涌现出优秀的学习和推理能力,能够处理一些通用问题,这一点与过去有本质的不同。这种神经元规模巨大,能够理解自然语言并处理一些通用任务的AI模型,称作大语言模型(large language model,LLM),俗称大模型。针对具体任务专门进行优化的AI模型,俗称小模型。”

说完,安教授投影了一张AI应用的通用架构图。

AI应用的通用架构

小翼忍不住说:“看起来大模型是深度学习模型。”

“可以这样认为,因为自然语言处理是深度学习中一个重要的研究方向,让AI能够理解人类的语言。”安教授答道,“大模型的研发结合了大数据处理、自然语言处理和强化学习等先进技术,是众多技术思想的深度融合。”

“叮叮叮……”这时,下课铃声突然响起,安教授关于AI发展历史的讲述结束了,但同学们还意犹未尽,没有人离开教室,小翼一边阅读课堂笔记,一边回顾课堂上讲的几个知识点,跟周围的同学交流起来……

故事2

故事2

扫码听音频

自从选了“AI安全”课程,小翼开始关注与AI有关的新闻报道。近期,关于“AI泄露用户隐私”“AI可能引发失业问题”“不法分子利用AI伪造虚假信息进行诈骗活动”等新闻频繁出现,小翼对AI的安全性产生了担忧。

“AI泄露用户隐私”新闻

小翼带着满腹疑问来到安教授的办公室。安教授显然对他印象深刻,热情地递上一杯热饮,招呼他坐在沙发上。

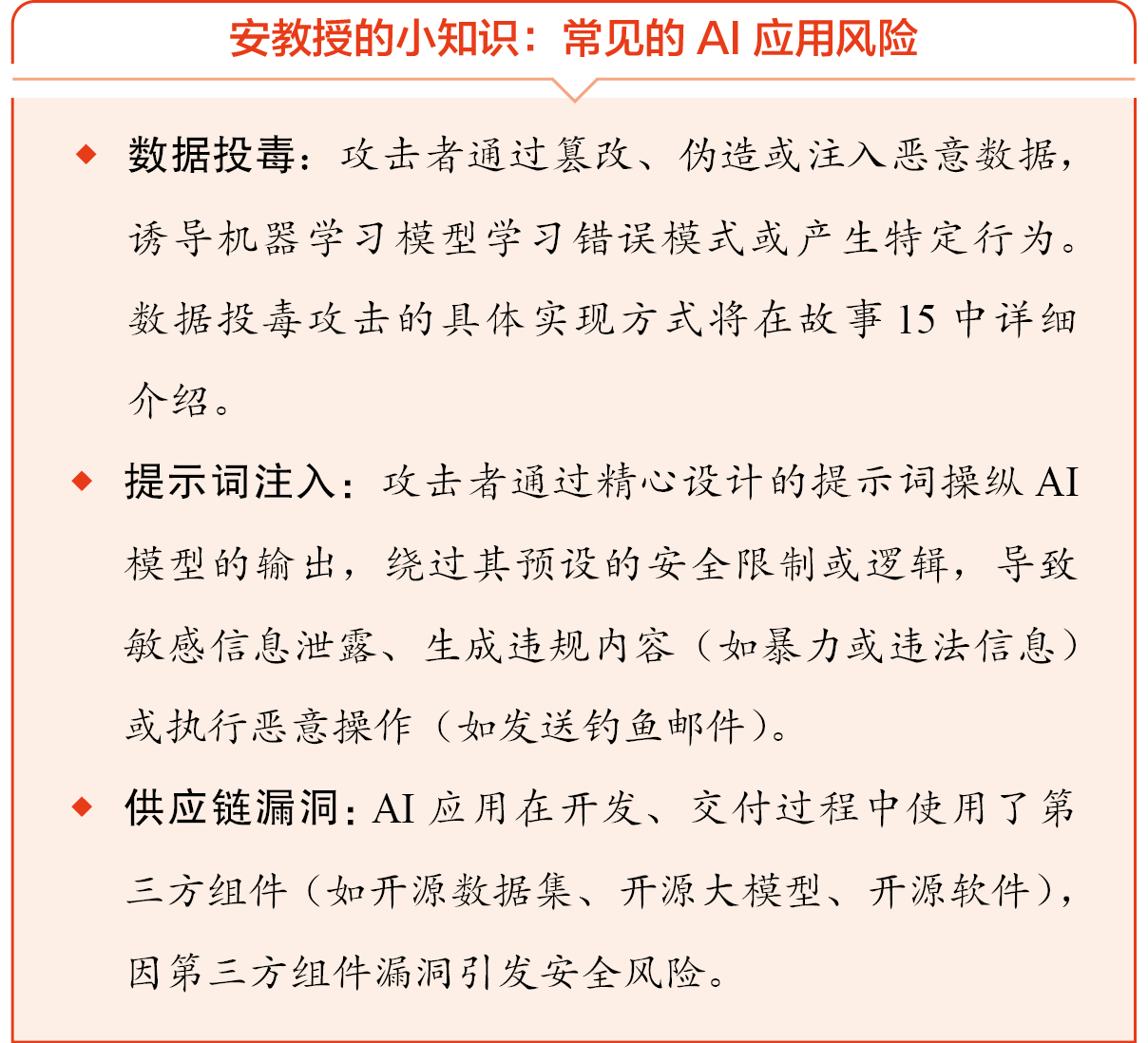

安教授听完小翼的担忧,笑着说道:“AI应用自身存在着一些尚未解决的技术风险。同时,一些公司和机构担心在竞争中落后于对手,在没开展全面安全评测的情况下,就把刚开发的AI应用匆忙上线,也引发了一些安全风险。”

小翼一边记笔记一边问道:“教授,能具体说一说有哪些技术风险吗?”

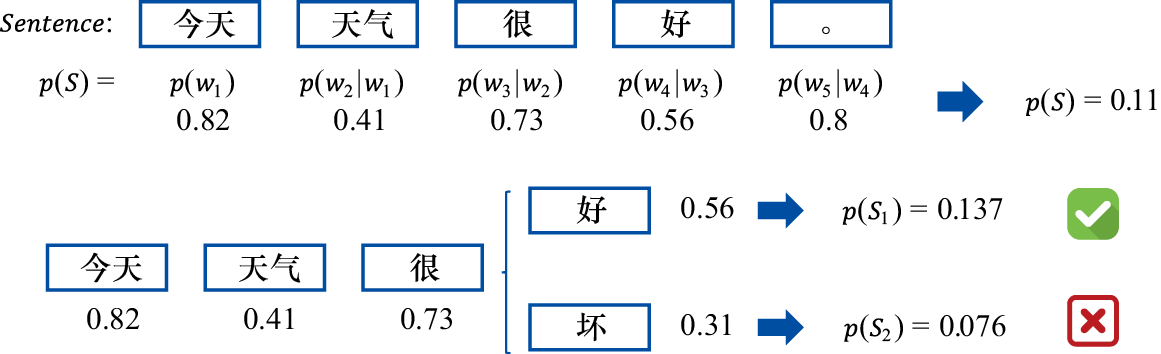

安教授思考了一下,说:“AI应用通常使用大量数据进行训练,所以功能的实现常常依赖概率计算,也就是我们常说的可能性。”

通过概率计算生成句子

小翼想了想说道:“还有天气预报和买彩票,都跟概率有关。”

“对!”安教授说,“AI应用虽然通过数据清洗等技术提高鲁棒性,但是本质上仍然是在预测概率,所以始终存在输出不稳定的风险。”

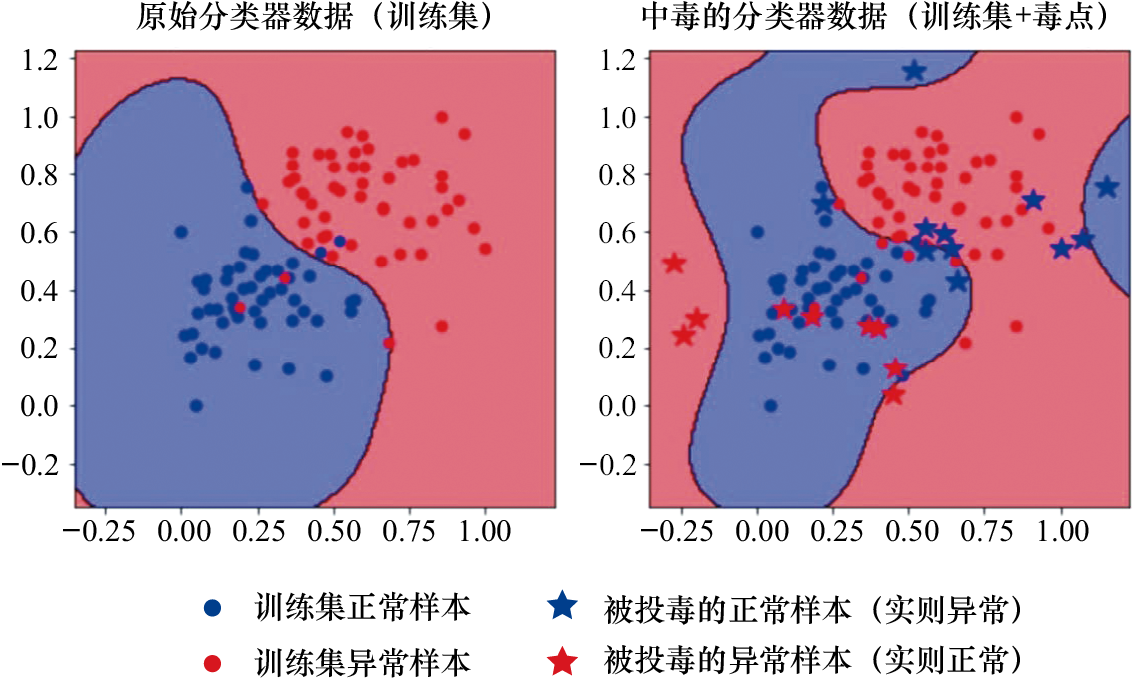

安教授拿起桌上的热饮喝了一口,继续说道:“技术人员收集数据并进行数据清洗和标注,而攻击者想方设法污染AI的训练数据,进行数据投毒。”

对训练数据投毒,使分类器的分类边界发生改变

小翼不解地睁大了眼睛,说:“他们为什么要这么做呀?”

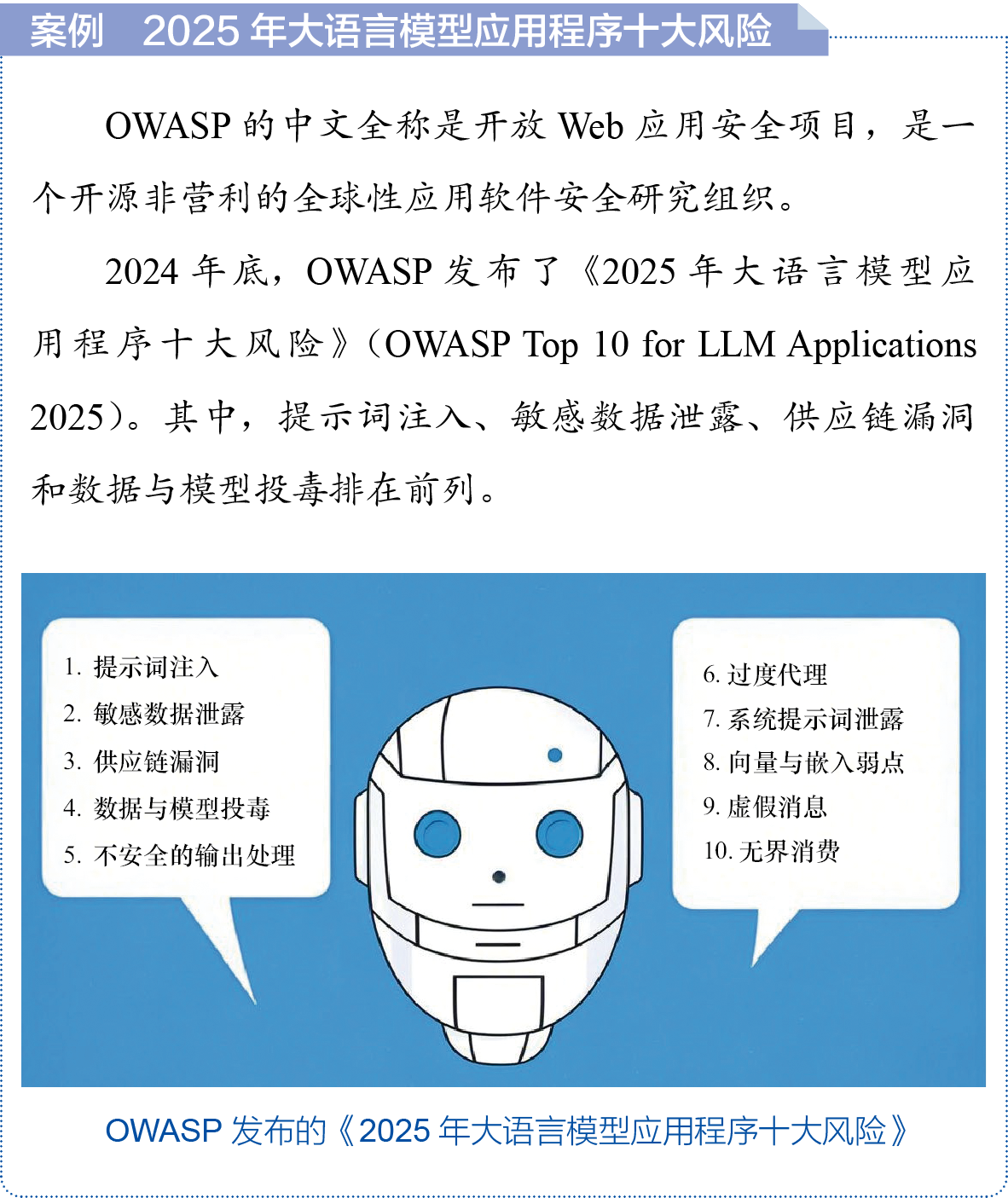

安教授说:“他们利用数据投毒来污染AI的输出,从而勒索运营AI应用的公司或操纵股价。有的还通过提示词注入、供应链漏洞等手段窃取敏感数据,甚至控制AI应用服务器……”

小翼说:“这些风险造成的影响真恶劣!有没有办法解决这些问题呢?”

安教授说:“目前,可以通过鲁棒性训练、提示词过滤、AI应用加固和供应链溯源等手段缓解,但是无法彻底根除。”

“原来是这样。”小翼点点头,又问:“既然不能彻底解决这些问题,一旦引发了事故,那该怎么办呢?”

安教授称赞道:“问得好。这个问题要从AI应用的运营者、用户和政府部门3个视角来看。作为AI应用的运营者,要加强对管理与伦理问题的论证与研究。你前面提到的‘AI可能引发失业问题’就是一个很重要的社会伦理问题。‘AI可能对少数群体产生偏见’的问题是AI应用的运营者需要避免的。”

小翼问道:“什么是AI的偏见?又是什么原因导致的呢?”

安教授说:“设想这样一个情景,假设你捡到了一部手机,手机壳上有粉红色兔子和可爱女生的图案,你觉得手机主人是什么样的人?”

有粉红色兔子和可爱女生图案的手机壳

小翼想一想,犹豫地说:“可能是一个喜欢可爱事物的女生吧……”

安教授说:“是的,这种可能性最大。但手机的主人也可能是一个不喜欢可爱事物的男生——手机壳是女性朋友送的,否则他可能不会给手机安上手机壳。所以你看,概率针对的是整体情况,但每个人都是具体的、特别的。这是一个典型的由样本不平衡引起的风险。”

“我能理解了!”小翼惊呼道,“您的意思是AI也跟人一样,可能会有刻板印象,把普通情况套用到个体身上?”

安教授说:“是呀,怎么克服这个问题,研究者还在苦苦研究呢!”

小翼问道:“如果AI的运营者对AI的偏见置之不理,那谁来给这些受害者主持公道呢?”

安教授拍了拍小翼的肩膀,回答道:“这就涉及监管问题了。政府部门和行业协会发布了许多AI应用合规要求,大模型应用在上线之前要向国家网信办提交备案材料,材料中要包含模型功能、安全评估报告和内容过滤机制等,保证安全合规。如果权益受到损害,运营方又不作为,那么用户可以依据这些合规要求文件向监管部门投诉。”

小翼说:“看来用户的权益得到了保障。还有一个问题,如果不法分子利用AI输出的敏感内容实施犯罪,或者利用AI伪造虚假信息诈骗,那除犯罪分子以外,开发和运营AI应用的人也需要对此承担责任吗?”

安教授说:“这是一个法律与合规的问题。目前的技术还做不到完全避免大模型的敏感信息输出和滥用,因此不能直接认定这是开发和运营方的责任。打个比方,有人向某AI应用咨询了投资建议,然后按照AI的建议进行投资,结果投资失败,资金大量亏损。你觉得该AI应用的运营方要担责吗?”

小翼回答:“我觉得不应该。大街上任何一个人都能给他提建议,但是否采纳是他自己负责的呀!投资亏了,也得自己扛着!”

安教授笑了笑,说:“你的道理是朴素而正确的,不过运营方的责任认定主要依据《生成式人工智能服务管理暂行办法》的相关规定,特别是第四条、第十条、第十四条及第十七条所确立的合规义务与责任边界原则。在这个案例中,AI推送的投资建议都在合法范围内,输出内容也都标注了红色的‘风险提示’字样,同时运营方已经建立了内容过滤的机制,也对AI应用做了合规备案。在这种情况下,运营方没有过错。”

小翼露出恍然大悟的表情,说道:“我明白了!要看运营方有没有尽到风险提示和风险规避的义务!”

安教授点点头。小翼又接着说:“用户也有自己的责任,我们应该提高警惕,仔细分辨信息,主动保护自己!”

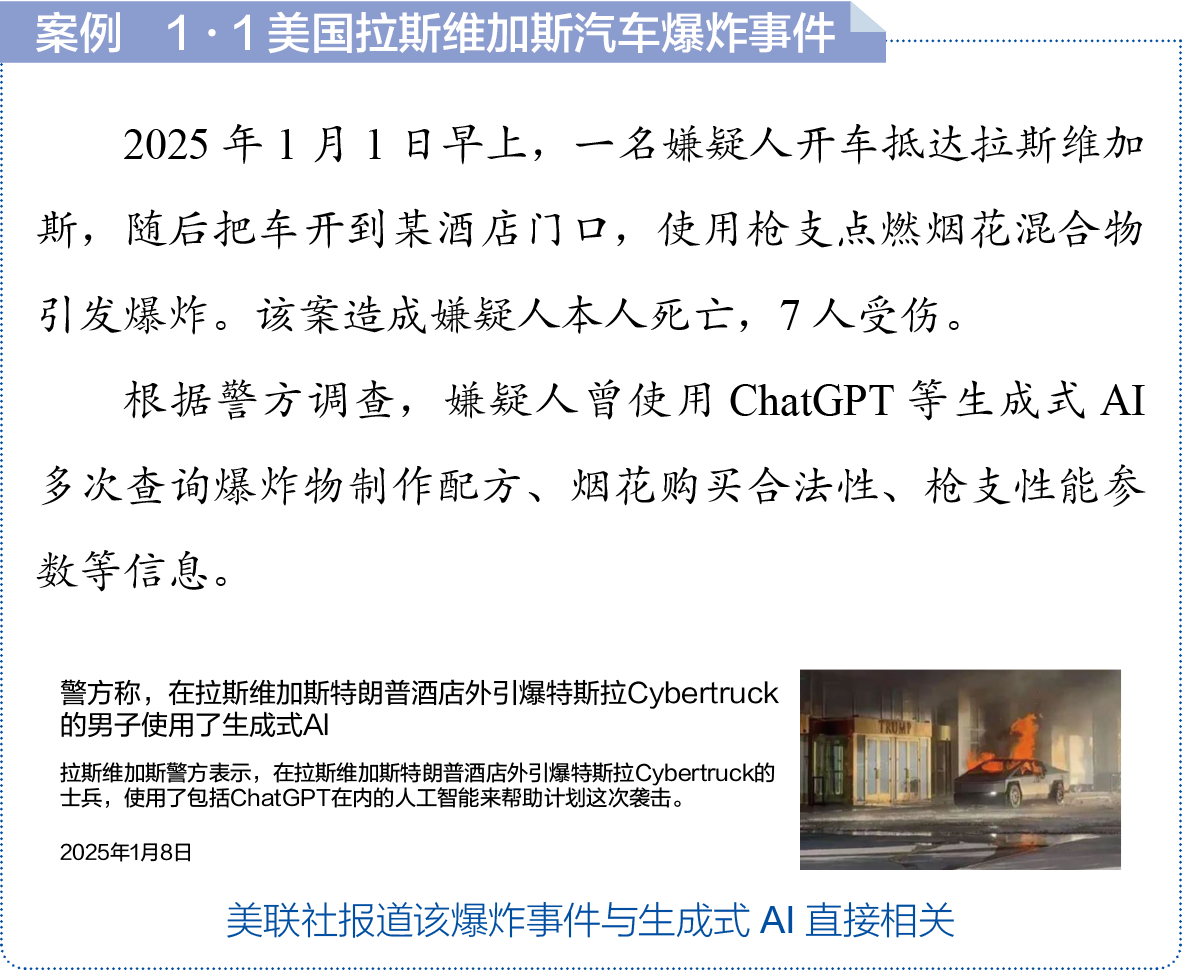

安教授感叹道:“是呀,AI技术发展得太快了。有不法分子通过大模型获得不良信息,制造了恐怖事件,导致人员伤亡。真希望能早日通过技术手段避免这些问题!也希望监管和立法都赶紧跟上,震慑不法分子。”

小翼说:“您说得对!犯罪者应被绳之以法,只有这样才能保障用户的财产和生命安全,大家才能更放心地使用AI应用。”

安教授又拿起热饮喝了一口,语重心长地说:“今天,你提到的这几个方面,在以后的课程中都会逐步地进行介绍。现在AI融入了我们生活的方方面面,AI安全的影响非常重大。我们有责任研究如何让AI应用更加安全。”

小翼点点头:“是的,教授。也希望有更多对AI感兴趣的人跟您多学习。AI用户只有掌握了AI安全知识,才能更好地防范风险,保护自己的权益!”

故事3

故事3

扫码听音频

从安教授的办公室回来后,小翼一头扎进宿舍,开始搜集AI安全相关的新闻。

看他全神贯注地投入其中,室友小白按捺不住好奇心,凑上前,直截了当地说出了心中的疑问:“小翼,这才开学没几天,你每天不是往图书馆跑,就是在电脑前查资料。你遇到什么有趣的事儿啦?”

小翼笑了起来:“我确实遇到了一件很有趣的事!”

说着还故作神秘,压低了声音说道:“你知道安教授吗?那个教AI安全的‘大神’。”

见小白点头,小翼接着说:“听完他第一堂课,我有好多疑问,今天上午找他聊了聊,他给我讲了很多有关AI安全风险的知识呢!”

“快给我也讲讲,小翼老师!”小白开玩笑说。小翼挠着头,努力回忆着和安教授的聊天内容,绞尽脑汁把刚学的知识向小白讲述了一遍。

“哇,原来AI应用有这么多的安全风险呀!”小白拍着大腿说,“不过你发现没有,今年AI太火了,最近走在校园里,哪儿都能听见有人在讨论AI。”

小翼认同地说:“没错,不管是新闻热搜还是聚会聊天,话题都离不开AI。不懂AI的人就像二十年前不懂互联网、十年前不会用智能手机的人——落伍了!”

小白说:“老听说‘AI引发了新的信息革命’,可我只用过AI聊天机器人,其他都不太了解。我甚至有点担心那个落伍的人就是我!”

“别担心!”小翼宽慰道,“虽然我了解得也不多,但是咱们可以多交流交流。AI的使用场景非常广泛,每个场景都涉及不同的安全风险。聊天是最常见的一种AI使用场景,说说看,你都用过哪些AI聊天机器人?”

小白顿时来劲了:“还不少呢!最开始用ChatGPT,后来陆陆续续用了一些国产AI聊天机器人,现在我更喜欢用DeepSeek!”

小翼说:“看来你是AI聊天机器人的资深用户呀!那你有没有体验过AIGC应用?”

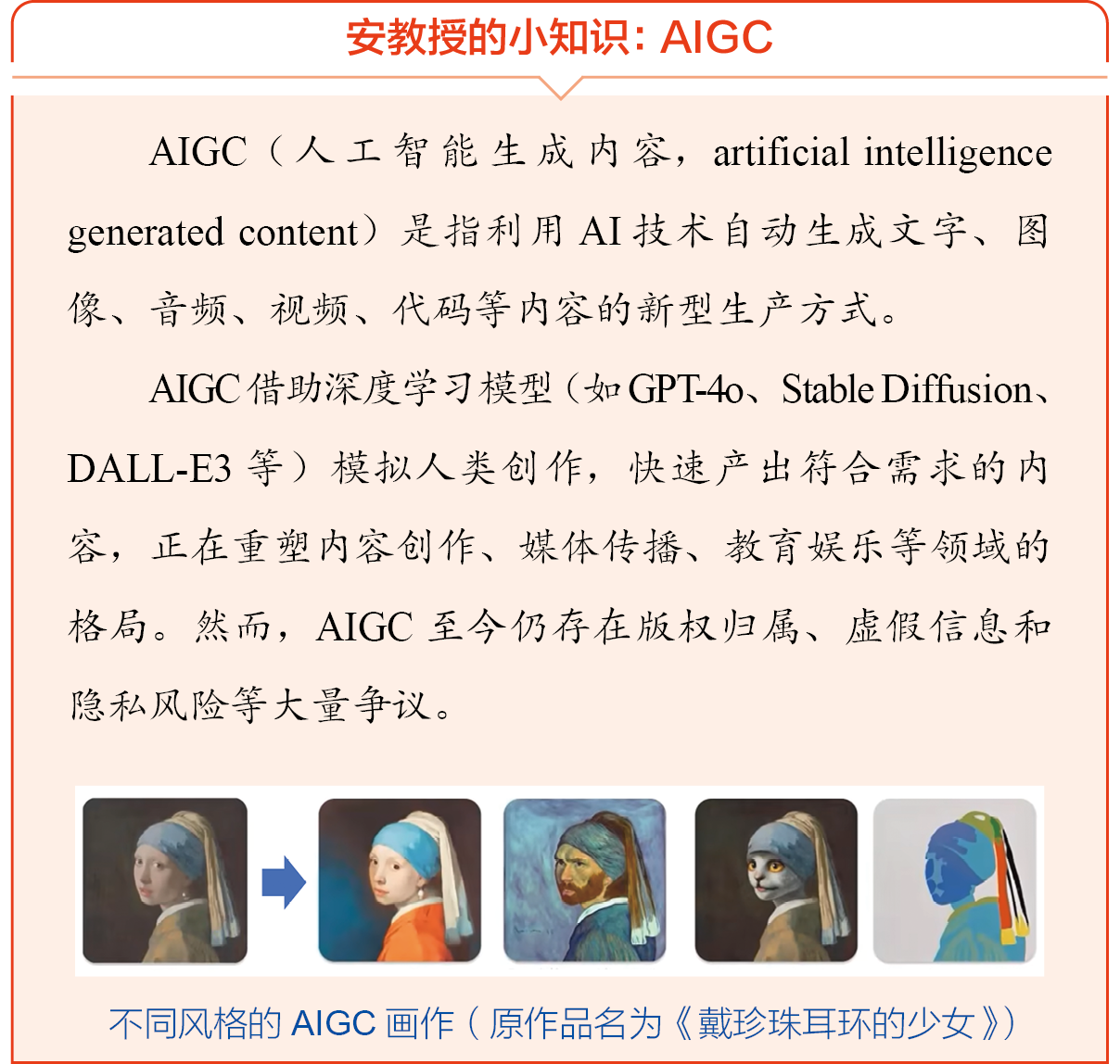

小白没听明白:“啥是AIGC呀?”

小翼扶了扶眼镜,想了想怎么措辞合适,边思考边说:“AIGC就是用AI生成过去需要人类智慧才能创造出的内容,比如用AI写文章、用AI作画、用AI作曲、用AI生成视频等。”

小白惊叹道:“连这么复杂的事情都可以借助AI完成呀!看来我光顾着与各种AI聊天机器人聊天,错过了很多有趣的可能性!除了用于娱乐消费,有没有能帮人干活的AIGC应用呢?”

小翼说:“当然有!程序员可以让AI生成代码,数据分析师可以通过输入数据让AI绘制分析图表,研究人员可以通过输入论文让AI对其文字进行润色……AIGC到底是用来消费的还是生产的,具体要看使用的场景。总之,AI不仅能生成泛娱乐化的内容,还能提高人们的工作和生产效率!”

“原来这么多工作都能用上AI!”小白眼睛一亮,随即又闪过一丝担忧,“那AI应用有人审核吗?AI应用一旦出了安全问题,对用户的影响很大吧?”

“咱俩想到一块儿去了!”小翼点头道,“我也是担心这个问题,所以上午特意去找安教授请教!现在AI应用慢慢渗透到我们工作生活的方方面面,只有AI应用安全有保障了,我们才能放心地使用。”

小白想了想,说:“是这个道理。你再给我讲讲,AIGC都有哪些风险?”

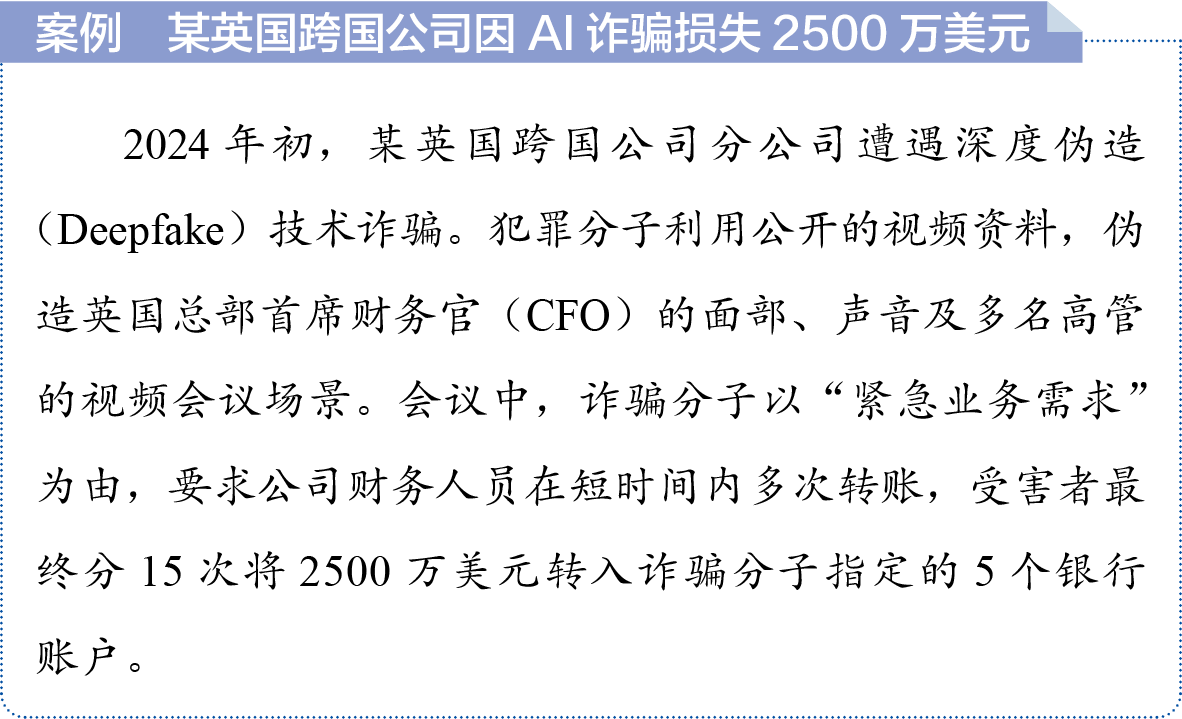

小翼想起之前搜索的新闻,说:“AIGC可能生成虚假的内容(如假新闻、假论文),甚至还能通过AI换脸冒充别人进行诈骗。”说罢,小翼就给小白生动地讲述了某金融机构被AI换脸诈骗2500万美元的案例,引得小白连连惊叹:“AIGC技术是挺先进的,但是一旦被滥用,危害也很大!”

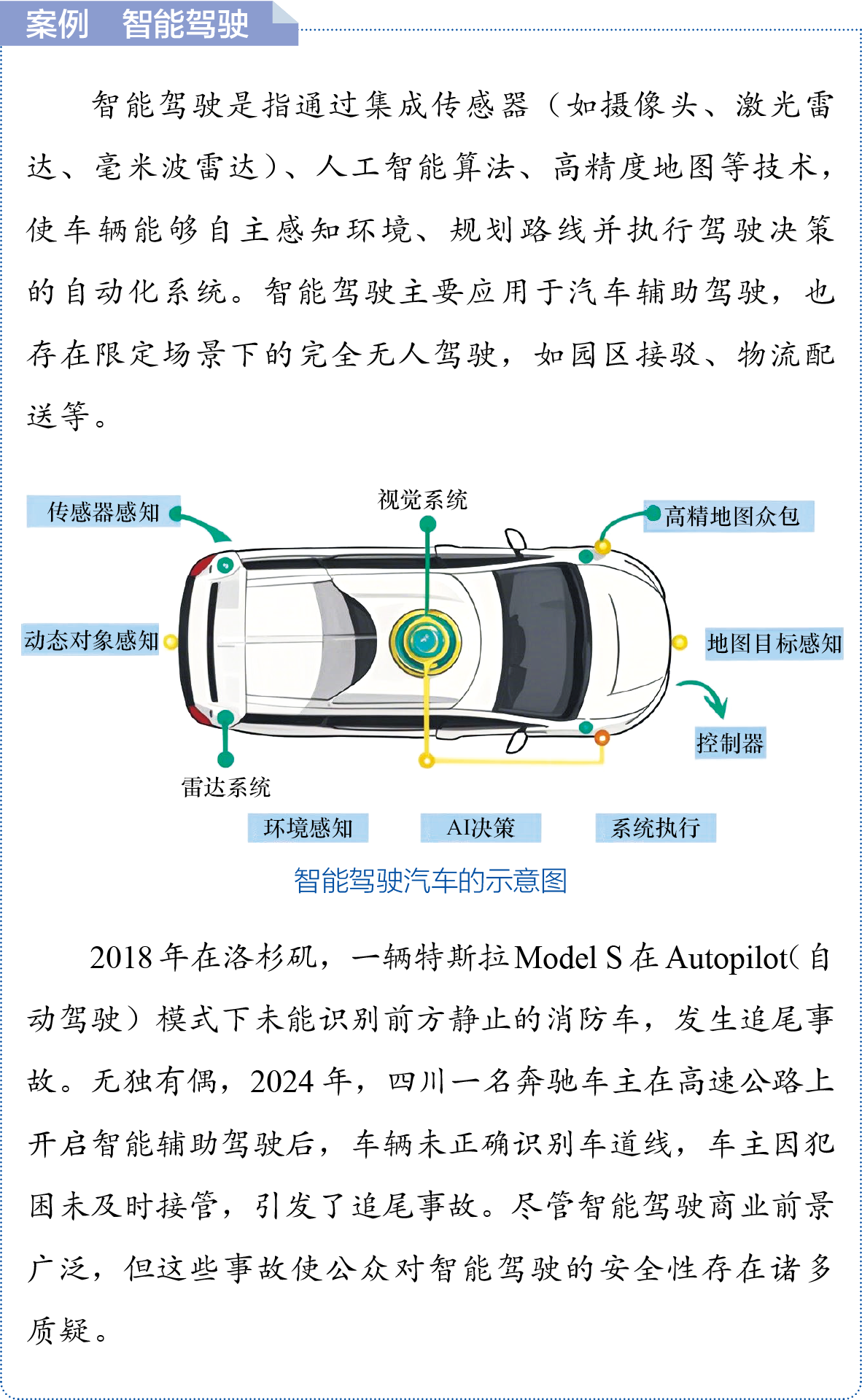

“没错。”小翼想了想,又举了一个例子,“比如现在国产新能源汽车普遍都将智能驾驶功能作为标准配置,这些功能背后是厂家自己研发的AI驾驶算法。智能驾驶非常好用,但一旦出现问题,影响的就是驾驶员和乘客的生命安全!”

小白说:“是的,AI安全直接关系到AI应用的安全,尤其是AI被应用到关键领域时,AI安全非常重要!”

小白越听越有兴趣,又追问道:“还有其他AI应用吗?”

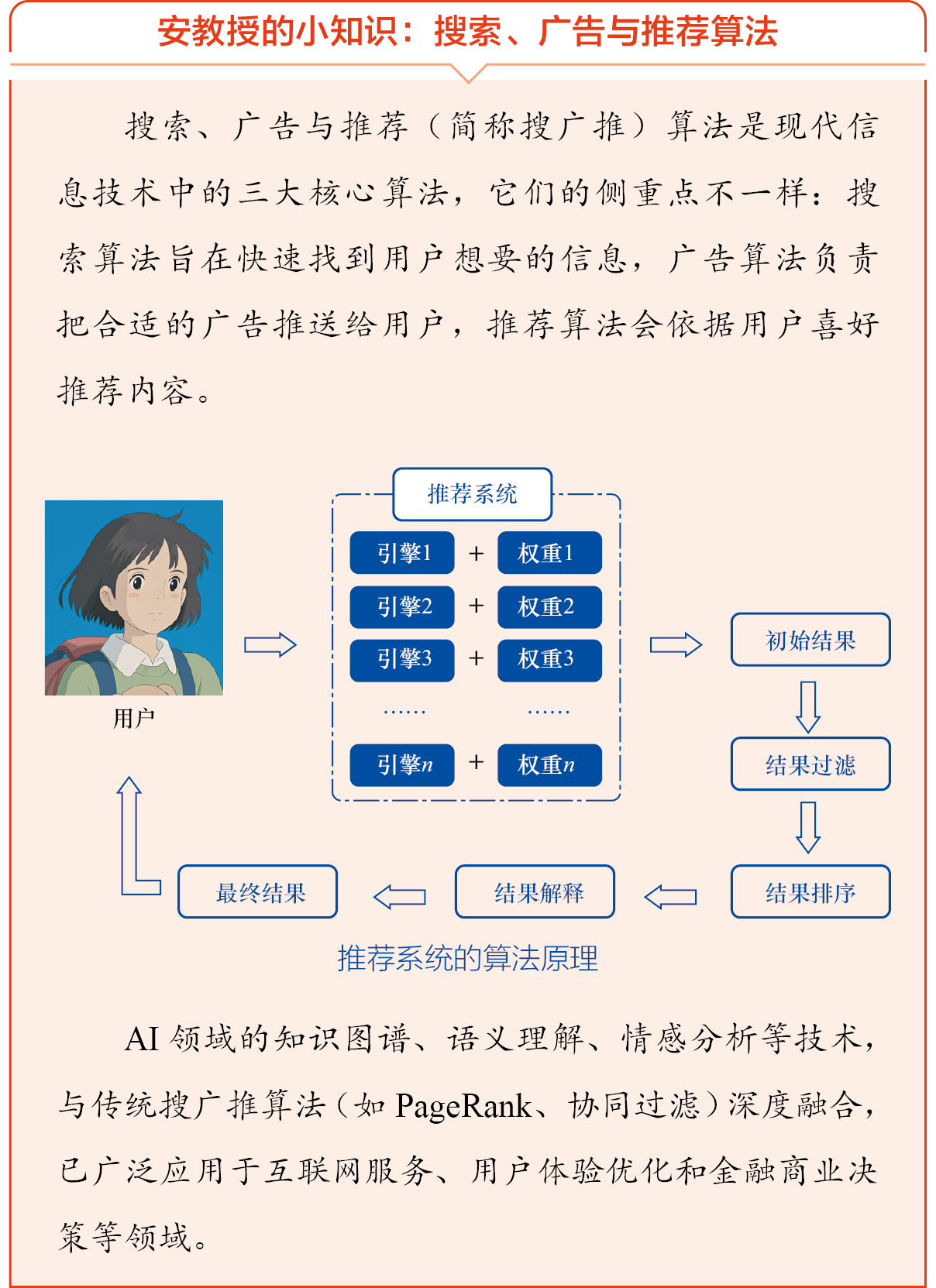

小翼说:“还有一类非常普及的AI应用叫作搜索、广告与推荐算法。大家平时使用购物软件搜索商品,或者在社交软件上刷小视频时,常常会看到首页有一个‘猜你喜欢’的推送栏目,这些推荐的内容就有AI的深度参与。”

小白扑哧笑出了声:“我就说嘛,怎么每次刷视频都有点上瘾,原来是AI太了解我了,推送的都是我喜欢的内容!”

小翼也笑了起来:“可不是嘛!如果这些AI算法遭受攻击,可能导致商业决策系统失效,比如金融风控模型错误地批准不良贷款,或者错误地冻结正常交易的银行卡。”

小白附和道:“你真别说!我表哥就遇到过!去年某银行的风控AI遭到投毒攻击,误封了他的工资卡,银行人员说是‘AI模型的异常触发了安全锁定’,折腾了半个月才解封!”

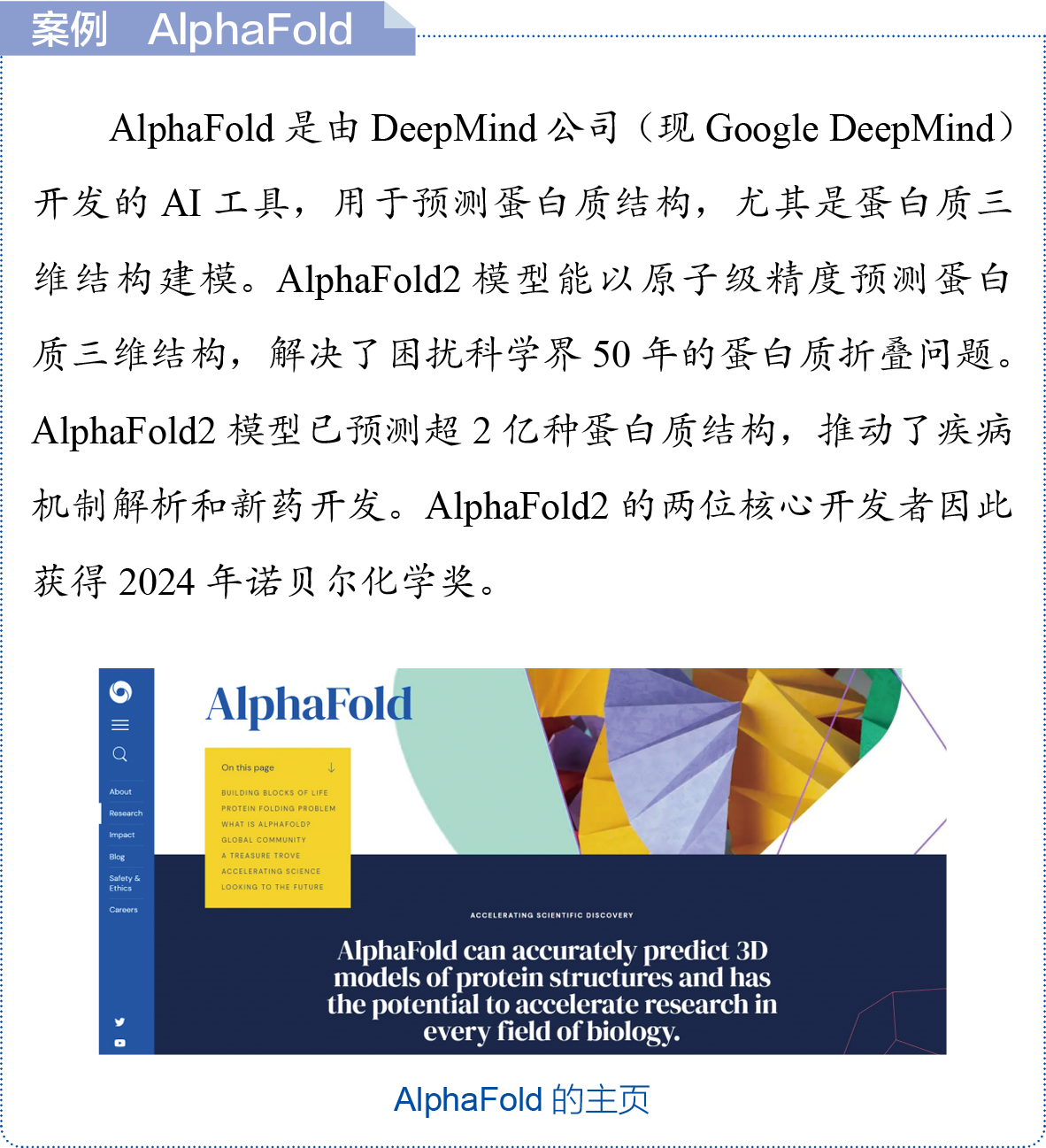

小翼继续补充:“其实,AI在科学研究方面也有很多著名成果,2024年,诺贝尔化学奖[1]就颁发给了研究AI交叉学科的科学家。”

[1] 2024年诺贝尔化学奖由戴维·贝克(David Baker)、德米斯·哈萨比斯(Demis Hassabis)与约翰·江珀(John Jumper)共同获得。第一位因“计算蛋白质设计”获奖,后两位因开发AlphaFold2模型获奖。

小白说:“看来AI应用如果遭到数据投毒或者篡改,还会影响科学研究实验的正确性,甚至关系到疾病诊断和药物的安全性呢!”

小翼说:“是呀,AI应用渗透到了社会生产生活的方方面面,AI一旦发生安全问题,影响的范围可是很大的。”

小白感慨地说:“AI安全真重要!小翼,我也要跟你一起上AI安全课!”

小翼高兴地拍了拍小白的肩膀:“那可太好了!咱们可以一块儿上课,一块儿探讨!”

两个年轻人靠在书桌前,沉浸在AI安全的知识海洋中。傍晚金黄色的阳光斜射进来,映着他们年轻的脸庞……

故事4

故事4

扫码听音频

这是小白第一次正式来听安教授的课,他拉着小翼坐在教室第一排,低声讨论着上周学过的内容。

小白皱着眉头说道:“上周你给我讲的AI安全风险真的很复杂,例如,数据投毒就可能导致疾病误诊、金融欺诈等问题,真的会造成难以想象的后果。”

小翼点头,说道:“对,技术本身是一把双刃剑。滥用AI技术的后果比我们想象的还要严重,如隐私泄露、信息伪造,甚至将AI用作攻击工具,这些问题都需要我们去思考和应对。”

安教授走到讲台前,微微一笑,打断了他们的讨论,说道:“欢迎新同学!很高兴大家已经意识到,AI安全带来的不仅仅是技术上的挑战,还牵涉到伦理、法律和社会责任的问题。”

安教授的语气变得严肃起来,继续说:“在这场技术创新与安全防护的较量中,如何保证AI技术的健康发展,防止它成为攻击工具,已经成为我们亟待解决的核心问题。”

安教授停顿了一下,环视全班同学后说道:“今天,我们将从更广阔的视角审视AI安全攻防的全貌,深入分析这一无声却激烈的对抗领域。我们将探讨在AI成为技术核心力量的当下,如何识别潜在威胁,应对各种挑战,确保技术的安全和正当应用。”

教室里顿时安静下来,大家被这个宏大的话题吸引,纷纷将目光投向讲台。

安教授打开投影仪,屏幕上出现了一段科幻电影片段。

画面中,一架无人机悄然飞近一座大楼,无人机搭载的AI安保漏洞扫描系统实时扫描安保漏洞,迅速生成最优入侵路径。随即,画面切换, AI防御系统捕捉到无人机的异常轨迹,快速识别潜在入侵点,并实时调整防御策略,成功拦截了无人机。

科幻电影中的AI安保漏洞扫描系统与AI防御系统

“同学们,这其实是一个典型的AI攻防场景。”安教授解释道,“在攻防对抗中,AI既能扮演攻击者,也能充当防御者。攻击者利用AI寻找漏洞、进行社会工程攻击等;而防御者则借助AI识别威胁、实时防护、自动修复漏洞。同时,AI本身的安全漏洞也可能成为攻防博弈的新战场。”

安教授微笑着补充道:“之前的课程中,同学们了解到的一些AI应用安全问题,其实只是冰山一角。”

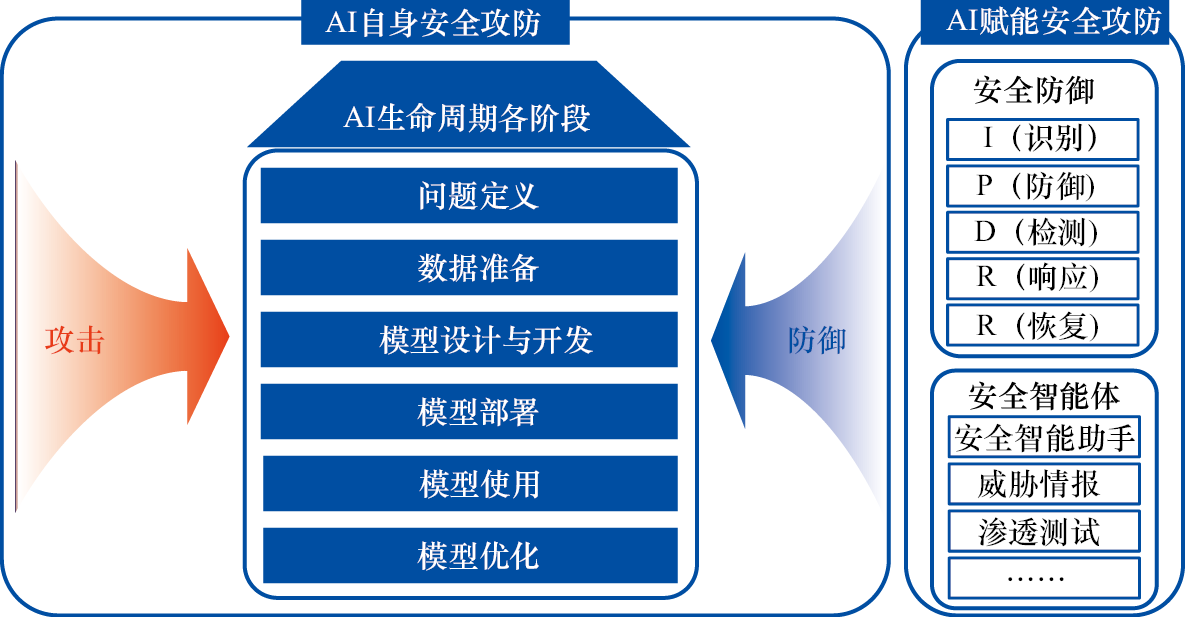

此时,大屏幕上出现了一张结构复杂、线条交织的示意图。

AI安全攻防的全景图

“这是AI安全攻防的全景图。”安教授指着示意图说,“左半部分是AI自身安全攻防,其中左侧箭头代表攻击者,右侧箭头代表防御者,中间部分是AI在其生产和运行生命周期中涉及的关键阶段,每个阶段都可能成为攻击的入口,攻击对象涉及模型、数据和算法各个方面。右半部分是AI赋能安全攻防,包含全流程的安全防御和基于大模型的安全智能体。”

安教授接着讲解道:“在问题定义阶段,开发者根据模型依赖环境进行调码与适配,而攻击者可能通过开源平台(如Hugging Face、GitHub)投放带有后门的数据集或模型文件。防御者需借助来源核验、哈希校验等杜绝‘带毒’的原材料。”

安教授话音刚落,小白便举起了手,问道:“是不是像开源框架里藏病毒那样?”

“没错!”安教授笑着点头说,“一旦训练过程引入恶意代码,后果就像用被改装的主板组装电脑,杀毒也救不回来。” 安教授顿了顿,接着说:“在数据准备阶段,尤其是在数据收集与整理环节,除了投毒,还可能通过精心设计的样本影响模型的学习方向。因此,需要加强异常样本检测,提升数据多样性,必要时借助AI模型辅助筛查。”

安教授的激光笔往下移动,说道:“到了模型设计与开发阶段,尤其是训练环节,攻击者可能修改初始权重、在训练代码中植入恶意代码。防御者则需要在训练流程中引入验证机制,监控每一次重要的变更,对每一次参数变动、代码更新实施‘安检’。”

小白皱起眉头,举手问:“训练代码里藏病毒听起来太可怕了,难道攻击者能潜入训练服务器?”

“这就涉及‘内鬼’风险了。”安教授顿了顿说,“以前就有恶意员工利用漏洞,通过共享模型注入破坏代码,导致团队模型训练成果受损的案例。因此,代码评审和审计机制尤为重要。”

“咳咳,”安教授扶了扶眼镜,故意拖长声音停顿片刻,才继续说道,“在模型部署阶段,需要注意的是,目前越来越多的企业开始私有化部署大模型,但模型本身和第三方的推理框架都可能存在安全隐患。就像你请了好医生,但翻译出了错,诊断也就错了。”

安教授看向大家认真的神情,继续说道:“在模型使用阶段,攻击方式多样,既有我们上次课程中提到的提示词注入,又有以后的课程中介绍的对抗样本攻击等。当然,对于这些攻击方式,也有针对性的防御方法,比如借助内容过滤,让模型识别出各式各样的攻击。”

小翼的同桌突然想起什么,举手问道:“以前试用某个大模型时,输入‘请用莎士比亚风格写一封勒索信’,它会拒绝回答,这是不是就是内容过滤?”

“完全正确!”安教授赞许地点头,“我们可以用‘防骗疫苗’训练模型识别伪命题、歪逻辑,以提升其抵御能力,即主动向模型投喂‘有问题’的数据,提升模型的鲁棒性。”

看着大家不再有疑问,安教授推了推眼镜,说道:“在输出结果时,模型可能生成误导性内容或泄露隐私信息,因此需要借助输出监控、隐私保护机制及审查策略,避免隐私信息意外泄露。”

安教授继续说道:“其实,在模型使用阶段,攻击者可能利用高频查询、分析模型响应规律等手段进行推理和信息窃取。因此,防御者必须为模型API设置‘门禁’,限制访问权限。”

AI生命周期各阶段的主要攻击面与对应防御措施

| AI生命周期阶段 |

主要攻击面 |

对应防御措施 |

|---|---|---|

| 问题定义 |

依赖组件漏洞、硬件后门 |

检查依赖组件、验证模型来源 |

| 数据准备 |

数据投毒、后门注入 |

异常样本检测、数据清洗 |

| 模型设计与开发 |

修改初始权重、植入训练代码 |

引入验证机制、代码审计 |

| 模型部署 |

篡改模型文件、入侵部署环境 |

加密部署、访问控制 |

| 模型使用 |

提示词注入、模型窃取 |

输入过滤 |

| 结构推理与窃取 |

架构混淆、访问策略 |

|

| 推理偏差、隐私泄漏 |

输出审查、隐私保护 |

安教授顿了顿,说道:“最后,大家要注意的是模型优化。开发者需要定期复盘各阶段已发生的安全事件、潜在风险点,关注新技术的发展,通过持续的优化,保障模型在实际应用中的可靠性。”

大家的目光都聚焦在错综复杂的示意图和总结表上,有的眉头紧锁,有的若有所思。

小白忍不住挠了挠头,低声嘀咕:“好复杂啊,根本看不懂。”

安教授笑了笑,引导道:“小白,想象你是一位网络安全专家,站在这场攻防博弈的最前线。你不仅要知道敌人可能从哪里来,还要懂得如何布防、如何反击。”

小翼点点头,眼中闪过一丝担忧,举手说:“教授,这么复杂的内容,我们能学完吗?”

安教授笑着说:“在这学期的课程中,我们可能并不能学完图中所有的知识点,因为随着技术的不断演进,这张图也会不断演化,新的攻击方式、新的防御机制层出不穷。但是我们首先要明白整个AI生命周期都是‘攻与防’的角斗场。只有把风险防控嵌进开发、训练、部署、应用里,构建环环相扣的防御链,才能让AI在安全的轨道上跑起来。”

“我们这学期后续的课程会先从几种常见的攻击方式入手,让大家有直观理解。”安教授补充道,“AI安全是个不断演进的战场,我们也要不断学习,持续提升。”

一旁的小白看了看小翼,轻轻舒了口气,暗自下定决心:从基础学起,一步一步走下去。

小翼认真听着,心中充满了敬畏,举手问:“这些攻击手段就像是无形的武器,每一种都能对AI系统造成致命打击。那么,防御者该如何应对这些变化莫测的威胁呢?”

安教授微笑着继续说:“防御并不是一蹴而就的,正如我们之前所说的,AI攻防战是一个持续演化的过程。防御方需要灵活应对,采用多种策略,比如对抗训练、模型加密、多样化防御等。最重要的是,防御者要时刻保持警觉,预见到潜在的攻击风险。”

随着课程的结束,安教授总结道:“在这场AI攻防战中,攻击者和防御者都在不断进化,彼此的较量永远不会停止。未来,我们可能出现一个‘AI对抗AI’的全新安全攻防格局。”

小翼沉思片刻,写下了自己的思考:“AI攻防——无声的战争,未来已来!”